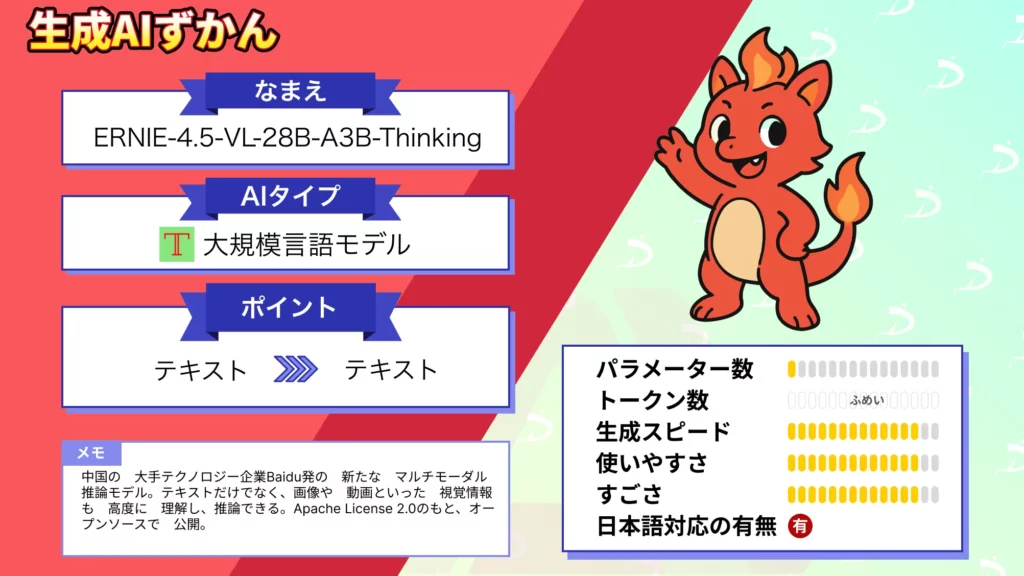

- 中国の大手テクノロジー企業Baidu発の新たなマルチモーダル推論モデル

- テキストだけでなく、画像や動画といった視覚情報も高度に理解し、推論できる

- Apache License 2.0のもと、オープンソースで公開

2025年11月11日、中国の大手テクノロジー企業Baiduは、新たなマルチモーダルAIモデル「ERNIE-4.5-VL-28B-A3B-Thinking」を公開しました!

このモデルはテキストだけでなく、画像や動画といった視覚情報も高度に理解し、推論できる点が大きな特徴です。

全体のパラメーターは280億にも及びますが、Mixture-of-Experts(MoE)という特殊な構造により、実際の推論時には30億程度のパラメーターのみを活性化して動作します。そのため必要な計算資源が抑えられ、たった1枚の80GB GPUで動作可能という効率性を実現しているようです。

本記事では、ERNIE-4.5-VL-28B-A3B-Thinkingの概要や性能、使い方まで徹底的に解説します。

ぜひ最後までご覧ください。

\生成AIを活用して業務プロセスを自動化/

ERNIE-4.5-VL-28B-A3B-Thinkingの概要

「ERNIE-4.5-VL-28B-A3B-Thinking」は、Baiduのオープンソース大規模言語モデルファミリーであるERNIE 4.5シリーズに新たに加わった視覚と言語の統合モデルです。

モデル名の「VL」はVision-Languageを、「Thinking」は高度な推論能力を示しており、その名の通り画像やテキストを組み合わせた複雑な問いにも推論を行えることが特徴です。

ERNIE 4.5シリーズには全部で10種類のモデルが存在し、目的に応じてサイズや能力が調整されていますが、その中でも本モデルは画像対応かつ高機能な軽量モデルとして位置付けられます。

技術的には、MoE (Mixture-of-Experts) アーキテクチャを採用し、総パラメーター数は28B(280億)ながら、入力ごとに最適な専門家ネットワークのみを動員して約3B(30億)のパラメーターを活性化します。

これにより、大規模モデルでありながら計算効率を飛躍的に高めているのです。

モデルは、まず基本となるERNIE-4.5-VL-28B-A3B構造上で事前学習され、その後「Thinking」と呼ばれる追加学習フェーズを経て推論能力を強化しています。

特に、中間段階の追加学習によって、大規模で多様な高品質の画像と言語の推論データを吸収し、視覚情報とテキスト情報の意味的な対応付け(アラインメント)が深まったとされています。

加えて、本モデルでは強化学習を用いた高度なチューニングが行われています。

検証可能なタスクに対するマルチモーダル強化学習として、GSPOやIcePopといった手法を組み合わせ、学習の安定化と効率化を図りました。

また、コミュニティからの要望に応える形で、指示に従って画像中の対象物を指し示す「グラウンディング」機能が大幅に強化されています。

例えば「画像中の○○を強調して」といった要求にも、より正確かつ容易に応答できるようになりました。

さらに「画像で考える(Thinking with Images)」という革新的な機能も搭載されています。これは人間が画像を見る際に全体を俯瞰した後、必要に応じて細部に目を凝らすように、モデルが画像を動的にズームイン・ズームアウトしながら細かな情報まで検討できるというものです。

以上のように、ERNIE-4.5-VL-28B-A3B-ThinkingはBaiduが提唱する次世代のマルチモーダルAIエージェントの土台となるモデルです。

画像と言語の深い理解力と効率的な計算資源利用を両立しており、研究者・開発者がビジュアルと言語の両面でこれまでにないアプリケーションを生み出すことを可能にしてくれそうです。

ERNIE-4.5-VL-28B-A3B-Thinkingの性能

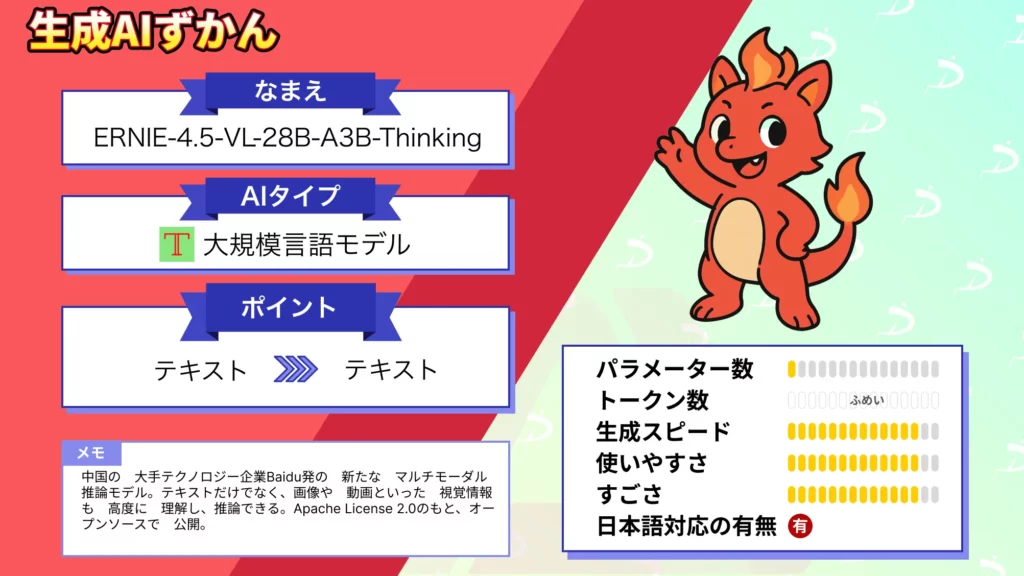

ERNIE-4.5-VL-28B-A3B-Thinkingの性能は、サイズ効率の良さとマルチモーダル能力の高さが際立ちます。

まずベンチマークスコアに関して、Baiduは本モデルが各種指標で業界トップクラスの大型モデルに匹敵する成果を挙げていると報告しています。

具体的には、3B(30億)のアクティブ・パラメーターで動作する軽量モデルでありながら、マルチモーダル分野の主要なベンチマークの多くでフラッグシップ級モデルに迫るスコアを記録しています。

特に、図表の読み取りや因果関係の推論といった視覚的な多段推論課題では卓越した能力を示し、複雑なグラフやチャートから意味を読み解く力は非常に高いとされています。

また、STEM分野の問題解決においても高い性能を発揮し、写真で与えられた数学や物理の問題を解いたり、工程図から論理的な回答を導き出すといった高度なタスクで大きな飛躍を遂げました。

例えば技術レポート中のケーススタディでは、画像で提示された幾何学の問題を論理立てて解答する能力が示されています。

ERNIE-4.5-VL-28B-A3B-Thinkingのライセンス

ERNIE-4.5-VL-28B-A3B-Thinkingは、Apache License 2.0(Apache 2.0 ライセンス)の下で公開されています。

Apache 2.0は、非常に寛容なオープンソースライセンスであり、商用利用から改変・再配布まで幅広く許可されるのが特徴です。

| 利用用途 | 可否 | 備考 |

|---|---|---|

| 商用利用 |  | |

| 改変 |  | |

| 配布 |  | |

| 特許使用 |  | |

| 私的使用 |  |

ERNIE-4.5-VL-28B-A3B-Thinkingの料金

ERNIE-4.5-VL-28B-A3B-Thinkingそのものはオープンソースのモデルですので、ライセンス料や使用料といった直接のコストは発生しません。

誰でも無料でモデルの重みデータをダウンロードし、自前の環境で実行できます。

したがって、料金という観点では、主に「モデルを利用するために必要な計算資源(クラウド費用など)」か、あるいは他社サービス経由で利用する場合のAPI利用料のみとなります。

| 利用方法 | 料金 |

|---|---|

| 自己ホスト (オンプレ/クラウド) | 無料(モデル利用料なし)※要80GB GPU |

| API経由の利用 (OpenRouter等) | 入力: $0.14/100万トークン 出力: $0.56/100万トークン |

| 参考: 他社大型モデルのAPI | 例)Claude Sonnet 4.5: 入力 $3/100万トークン、出力 $15/100万トークン |

ERNIE-4.5-VL-28B-A3B-Thinkingの使い方

こちらでは、Hugging Faceの公式モデルカードに掲載されているクイックスタートをベースにした使い方を紹介します。

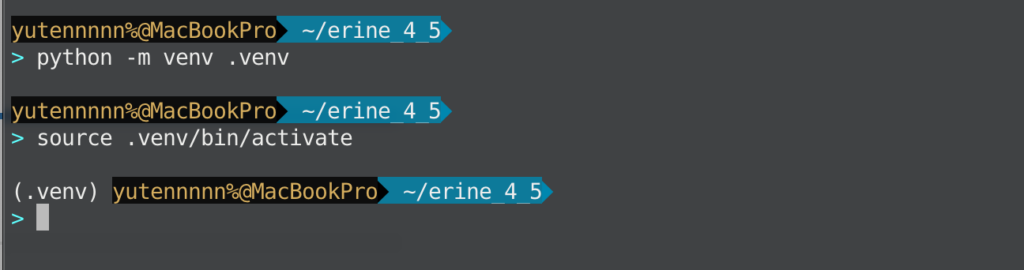

環境構築

まず環境を整えます。新しい仮想環境を作って、必要なライブラリを入れましょう。

PyTorchはGPUがあると快適ですが、CPUでも一応動きます(少し待ち時間が増えます)。

# 仮想環境の作成と有効化

python -m venv .venv

source .venv/bin/activate # Windows は .venv\Scripts\activate

# 推論に必要な最低限のパッケージ

pip install -U torch transformers accelerate pillow

準備ができたら、画像を見て答えさせるための最小スクリプトを走らせてみましょう。以下のコードはモデルカードの「Using transformers Library」をベースにしたものです。

# file: quickstart_ernie45_vl_local.py

import torch

from transformers import AutoProcessor, AutoModelForCausalLM

MODEL_ID = "baidu/ERNIE-4.5-VL-28B-A3B-Thinking"

# 1) モデルとプロセッサをロード(カスタム処理を使うため trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained(

MODEL_ID,

device_map="auto",

dtype=torch.bfloat16,

trust_remote_code=True

)

processor = AutoProcessor.from_pretrained(MODEL_ID, trust_remote_code=True)

# 画像の前処理をモデルに紐づけ(公式の推奨呼び出し)

model.add_image_preprocess(processor)

# 2) ユーザーの“メッセージ”を定義(テキスト+画像URL)

messages = [{

"role": "user",

"content": [

{"type": "text", "text": "この写真の女の子の服の色は?"},

{"type": "image_url", "image_url": {

"url": "https://paddlenlp.bj.bcebos.com/datasets/paddlemix/demo_images/example1.jpg"

}}

]

}]

# 3) チャット用テンプレートに流し込み → 画像を前処理 → テンソル化

chat_text = processor.tokenizer.apply_chat_template(

messages, tokenize=False, add_generation_prompt=True

)

image_inputs, video_inputs = processor.process_vision_info(messages)

inputs = processor(

text=[chat_text],

images=image_inputs,

videos=video_inputs,

padding=True,

return_tensors="pt",

)

# 4) 推論(メモリ節約のため use_cache=False は公式サンプルと同じ)

device = next(model.parameters()).device

inputs = inputs.to(device)

with torch.inference_mode():

out_ids = model.generate(

inputs=inputs["input_ids"],

**inputs,

max_new_tokens=512,

use_cache=False

)

# 5) 生成トークンを文字列に戻して表示

answer = processor.decode(out_ids[0][len(inputs["input_ids"][0]):])

print("\n=== MODEL ANSWER ===")

print(answer)

実行してみて、もし出力が長すぎると感じたら max_new_tokens を 256 くらいに落としてみてください。モデルカードのサンプルでも use_cache=False を指定しており、少ないメモリで安定して回すのに役立つと思います。

以上、ERNIE-4.5-VL-28B-A3B-Thinkingの簡単な使い方の紹介でした。

ERNIE-4.5-VL-28B-A3B-Thinkingの活用可能性

最後にERINE-4.5-VL-28B-A3B-Thinkingの活用可能性をご紹介します。ぜひご自身のタスクの参考にしてみてください。

現場×ビジョンAIアシスタント

スマホや現場カメラで撮った写真・短い動画をそのまま投げると、部品名の特定や異常箇所の指差しまで自動で返します。

交換手順や必要工具も提案し、記録は画像付きで時系列に保存してくれます。

オンプレ環境で1枚の80GB GPUでも回せるので、機密情報を扱うような環境でも実運用しやすいのが強みです。新人教育や引き継ぎシーンにも効果的だと思います。

レポート自動化と可視化

ダッシュボードのスクショやPDFを渡すと、表や注記を読み取り、最大値・前年比・外れ値の理由を自然な日本語で説明してくれると思います。

質問に対して根拠となるセルや該当するグラフをハイライトしてくれて、RAGと連携することでデータソースも提示させることもできます。

定例レポートは差分検知機能で更新ミスを防いで、ドラフトを自動生成させることもできると思います。

ナレッジ支援

手書きノートや板書の写真から、定義→手順→結論の流れで思考を言語化することができると思います。証明の抜けや条件の見落としなどを指摘してくれて、別解のヒントも段階的に提示してくれます。

図や式を文章に言い換えて、読み上げ用の要約も自動生成してくれると思います。

まとめ

ERNIE-4.5-VL-28B-A3B-Thinkingは、最新世代のマルチモーダルAIモデルとして魅力的な特徴を備えています。

本記事では概要から性能評価、ライセンスや料金、具体的な使用方法と実験結果まで包括的に見てきました。感じられるのは、ERNIE-4.5-VL-28B-A3B-Thinkingが「少ない資源で多くをこなす」新しいモデルであるということです。

気になる方はぜひ一度試してみてください。

最後に

いかがだったでしょうか?

弊社では、AI導入を検討中の企業向けに、業務効率化や新しい価値創出を支援する情報提供・導入支援を行っています。最新のAIを活用し、効率的な業務改善や高度な分析が可能です。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。 ︎株式会社WEELのサービスを詳しく見る。

︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。 ︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。