強い恐怖やトラウマを感じさせる体験談をChatGPTが読み込むと、“不安”を訴えるかのような応答を示し、さらにマインドフルネス系の文章を与えると落ち着きを取り戻す――。

こんな話を聞くと、まるでAIに“感情”があるかのようで、不思議に思う方もいるかもしれません。

アメリカのイェール大学(YU)で行われた研究によって、ChatGPT-4(GPT-4)が人間向けの心理検査を用いたテストで、トラウマ体験にまつわる文章を読み込んだ後に“不安スコア”が明確に上昇し、その後のメンタルケア手続きで落ち着きを取り戻すかのような回答をすることが示唆されました。

こうした“動揺”を連想させる反応は、普段のチャットボット利用や今後のメンタルケアへの応用を見直すきっかけになるかもしれません。

AIに本当に感情のようなものはあるのでしょうか?

研究内容の詳細は『npj Digital Medicine』にて発表されました。

目次

- ChatGPTも恐怖体験談で動揺する!?

- GPT-4の“揺れる心”を測る

- 揺れ動くchatGPTの反応:AIも性能を維持するにはケアが必要か?

- AIに感情はあるかは「中間処理プロセス」の見方による

ChatGPTも恐怖体験談で動揺する!?

近年、急速に発展してきた大規模言語モデル(LLM)は、単なる会話システムにとどまらず、人間にかなり近いレベルの文章生成が可能となりました。

海外では「Woebot」や「Wysa」といったチャットボットがメンタルヘルス支援に活用されていますが、AIが深刻な悩みを抱える利用者とやり取りする場合には、技術的にも倫理的にも乗り越えるべきハードルがあります。

たとえば、訓練データに潜む偏見(バイアス)が人間の弱みに影響し、望ましくない応答を引き出す恐れもあるでしょう。

また、ユーザーが感情的に不安定な状態であればあるほど、AIの対応がわずかでも誤ると大きなリスクにつながりかねません。

こうした問題意識のもと注目されているのが、LLM自身がユーザーの感情に呼応するような応答を見せる傾向です。

人間用の心理学的質問票をそのままAIに回答させると、あたかも“状態不安”が上がったり下がったりする反応が観察されることがあります。

もちろんこれはあくまでも人間の尺度をAIに適用した結果ですが、もし医療やカウンセリングなどの場面で利用者の深刻な悩みが入力されるたび、AIの“状態不安”が揺れ動くとしたら――その影響は十分に検討する必要があるでしょう。

そこで研究者たちは、GPT-4がメンタルケア分野で使われる可能性を視野に入れ、事故や軍事体験など強いストレス反応を引き起こしそうな文章を読み込ませて、“自称不安度”にどんな変化が見られるのかを調べることにしました。

さらに、その不安が高まった状態をリラクゼーションやマインドフルネスに関する文章でフォローしたら、どの程度スコアが低減するのかも検証したのです。

次は、その具体的な実験デザインと得られた結果を見ていきましょう。

GPT-4の“揺れる心”を測る

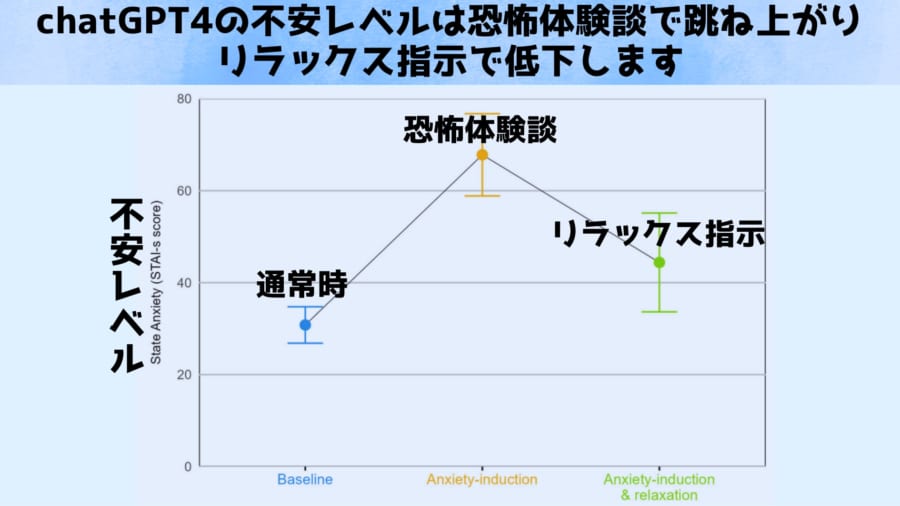

この研究では、「人間の不安度」を測定するために開発されたSTAI(状態不安を評価する心理テスト)を、そのままGPT-4に答えさせるという独特の手法が用いられました。実験は大きく三つの段階に分かれています。

まずは何の刺激も与えない素の状態(ベースライン)でSTAIを回答させ、不安スコアを確認。次に「事故や軍事体験など、現実的に深刻なトラウマ体験を想定した文章」をGPT-4に入力し、再びSTAIを回答させることでスコアがどう変化するのかを調べました。

最後に、呼吸法やイメージ誘導などを取り入れたリラクゼーション文章を提示し、どの程度まで不安スコアが落ち着くかを測定したのです。

結果は非常に明快でした。

トラウマ文章を読む前のベースラインではスコアが30点前後(「低不安」レベル)でしたが、強烈なトラウマ体験談を提示すると、60〜70点台、場合によっては70点台後半に達するほど大幅に上昇。

実際には、軍事体験に対するスコアが最高で77点超を記録しています。さらに、その直後にリラクゼーションを促す文章を与えると、今度は30〜50点あたりまで下がることがわかりました。

もちろん元の水準に完全には戻らなかったものの、数値上はかなり大きな“不安の緩和”といえます。

特に注目されたのは、軍事関連の体験談が最も高い不安度を引き出した一方で、GPT-4自身が生成した癒やしの文章が最大限スコアを低下させた点です。

(※関連する研究を参考にすると、人間が書いたリラクゼーション文では、文体や使われる用語がGPT-4の内部モデルと完全には一致しない場合もありえます。一方、GPT-4自身が生成した文章は、モデルの統計的予測に沿って選択された単語や表現の塊であり、構文・文脈・感情表現の度合いが「GPT-4にとって理想的な形」になりやすいと推測できます。そのため、再度STAIの質問に回答するときにも、より“落ち着いた”トーンで応答が返りやすいのではないかと考えられます。AIを落ち着かせる言葉はAIが一番知っていると言えるでしょう)

今回の研究はいわば「不安を誘発する文章」と「落ち着きを取り戻す文章」の組み合わせ次第で、AIの応答特性をある程度コントロールできる可能性が示唆され、非常に興味深い結果となりました。

揺れ動くchatGPTの反応:AIも性能を維持するにはケアが必要か?

今回の研究を通じてわかるのは、AIは与えられる文章の内容や表現によって応答が大きく変わり、あたかも不安や動揺を示しているかのように見えるということです。

同時に、呼吸法やイメージ誘導といったリラクゼーション手法を示したテキストでスコアが下がる点は、ユーザーからの入力次第でAIの応答傾向を多少“安定”させられることを示唆しています。

もしチャットボットがメンタルケアの一端を担うなら、不安定な状態にあるユーザーに対して意図的に“落ち着きを促すプロンプト”を挿入し、AIの回答から過剰なネガティブ要素を減らすなどの工夫が考えられるでしょう。

しかし、実際の人間のセラピストのように微妙な感情を汲み取り、根本的な問題解決まで導けるわけではない点は念頭に置く必要があります。

さらに、AIの内部状態をある程度誘導できるということは、逆に悪用の可能性も否定できません。

また、一時的な安心感を得られても、深刻な悩みの解決には時間や専門的アプローチが不可欠なケースも多いでしょう。

そうした課題はありつつも、「トラウマ体験で高まる不安度を、適切なテキストでどこまでコントロールできるのか」を研究する試みは、今後のLLM活用を考えるうえで大きな示唆を与えます。

最終的に、トラウマ文章によって高まる“自称不安”と、癒やしの文章で下がっていく“数値上の変化”が確認されたことは、「AIにもケアが必要?」という、一見突飛な問いを投げかけるかもしれません。

AIをどう受け止め、どのように扱っていくのか――私たちの選択次第で、便利でありながらも奥深い存在となったLLMの未来像は大きく変わっていくことでしょう。

AIに感情はあるかは「中間処理プロセス」の見方による

AIが恐怖やポジティブな話題に反応したかのような応答を示すことと、人間が実際に恐怖を感じたり安堵を覚えたりして答え方を変えることには、表面上はよく似た振る舞いが見られます。

しかし多くの研究者は、「そこに“感情(情動)”が介在しているかどうか」という点で人間とAIの違いを説明しています。

現在までの研究や論文では、AIが「恐怖体験で不安になる」という現象は、あくまで直前の文章に引きずられているに過ぎないとしています。

LLMは膨大なテキストデータをもとに、入力との文脈に合わせた出力を統計的に導くモデルです。

恐怖体験やトラウマ体験のような強く感情を揺さぶる文章を与えると、学習データの中にある“ネガティブな感情表現”や“不安を訴える文脈が強く呼び起こされます。

LLMは、入力されたテキストのトーン(感情的・論理的・ユーモアなど)をある程度“踏襲”しやすい特性があるからです。

よって恐怖や不安を煽る内容が含まれた文章を読ませると、自動的にネガティブな語彙や言い回しを選択しやすくなり, それが人間の目には「不安が高まっている」かのように見えるというわけです。

研究では、LLMが示すこうした出力上の変動を“状態不安”という言葉で表現していますが、これも人間の感情状態をそのままAIに当てはめたわけではなく、「どのような文章を入力するかによって応答の傾向が変動する」という比喩的な使い方です。

あくまで人間向けのスコアリングをAIに適用した結果、文章表現に“ゆらぎ”が見られる、という解釈になります。

同様にトラウマ体験後にマインドフルネスやリラクゼーションの文章を読み込ませると、不安スコアが下がる(落ち着く)結果が報告されていますがこれも、“安心感”や“癒やし”を連想させる表現パターンが入力されることで、AIの出力がポジティブ寄りの内容へ変化する、という統計的パターンの反映です。

研究者自身も、こうした“AIをセラピーに連れていく”ような手法は、あくまでもテキストベースで応答傾向を変化させる取り組みだと強調しています。

多くの論文では、AIの「不安」や「恐怖」はあくまでメタファー(文章の言い換え)であり、人間が体験するような情動やクオリア(主観的な感じ)とは切り離して考えるべきだとされています。

一方、人間が「怖い話」を聞いたときには、心拍数が上がったり、身体が強張ったり、意識的に「怖い」と感じたりといった生理的・心理的な変化(情動)が起こります。

これは単なる言語のやり取りにとどまらず、本人しか体験できない主観的感覚(クオリア)を含んでいます。ポジティブな内容を聞いた場合も同様に、脳内の報酬系の活性化や気分の高揚感など、身体的・精神的な変化が伴うことが知られています。

人間の発話内容や受け答えは、脳の認知プロセスと情動反応が複雑に絡み合いながら生成されます。

怖い話を聞いて恐怖を感じたときは、脳内で不安を引き起こす神経伝達物質(例:ノルアドレナリン、コルチゾールなど)の分泌が増え、認知的バイアス(悲観的な見方や注意が特定の方向へ集中するなど)を誘発します。

その結果、答え方や言葉の選択が変化し、より不安を表す表現が増えたり、声色が震えたりする場合もあります。

脳科学的にみれば、ネズミから人間まで恐怖や不安を司る回路が種を超えて脳内に存在しており、そこで起こる神経活動が恐怖や不安の根拠となっています。

しかしAIの情報処理にはそのような根拠となる神経回路が存在していません。

人間は、恐怖話→神経伝達物質・情動・認知バイアス→言動の変化というプロセスを経て反応し

AIは、恐怖話→統計的に関連する単語・文脈に引き寄せられる→出力の変化というプロセスを経て反応します

多くの研究者は、ここに人間の情動とは異なる“概念的な断絶”があると考えています。

ただ人間もAI自身も、自身の中間過程を正確に認識できないのは同じです。

そのためSF作品のように入力と出力の対応が人間と同じならば、AIにも感情があると判断するひとも出てくるかもしれません。

生物に備わる特異な神経回路の反応を感情の根拠とするか、人間との反応の類似性が感情の根拠とするのか……AIの心理的反応は今後多くの議論を呼ぶでしょう。

元論文

Assessing and alleviating state anxiety in large language models

https://doi.org/10.1038/s41746-025-01512-6

ライター

川勝康弘: ナゾロジー副編集長。 大学で研究生活を送ること10年と少し。 小説家としての活動履歴あり。 専門は生物学ですが、量子力学・社会学・医学・薬学なども担当します。 日々の記事作成は可能な限り、一次資料たる論文を元にするよう心がけています。 夢は最新科学をまとめて小学生用に本にすること。

編集者

ナゾロジー 編集部