- 企業IT動向調査2025で生成AI導入企業の約4割が「期待した効果が出なかった」と回答

- 成功を左右するのは「目的の明確化」「運用体制」「リテラシー」

- 導入前に潜むリスクを洗い出し、成果へつなげよう

生成AIは業務に役立つ技術ですが、導入目的が曖昧なまま導入を検討したり、ガバナンス不備やリテラシーが不足したりすると、導入に失敗するといったケースが存在します。企業IT動向調査2025では、生成AIを導入した企業のうち38.7%が「成果が出なかった/PoCで止まった」と回答されました。

この記事では、よくある失敗パターン、リスクのチェックポイント、業界別の成功パターン、2025年以降の法規制動向を解説します。

\生成AIを活用して業務プロセスを自動化/

生成AI失敗が急増する背景

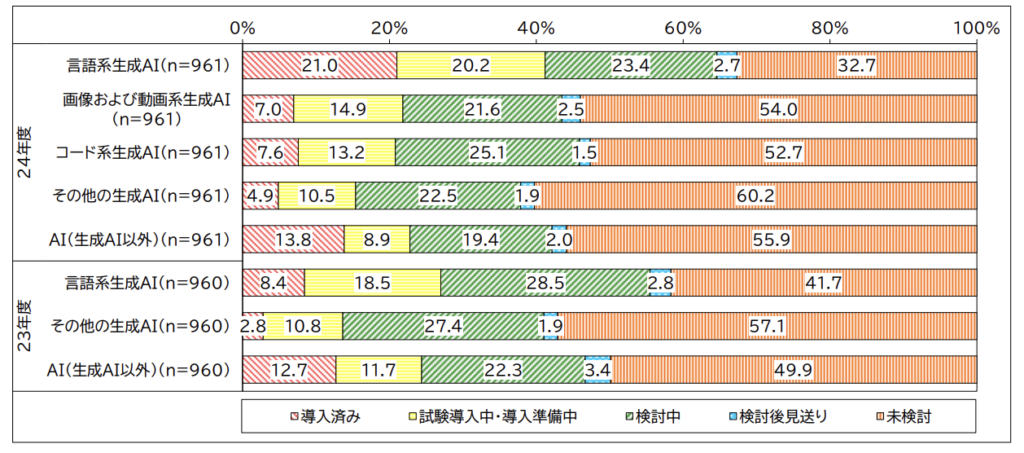

一般社団法人 日本情報システム・ユーザー協会(JUAS)による「企業IT動向調査2025」によると、言語系生成AIを「導入済み」または「導入準備中」を含めた企業割合は 41.2% に達し、前年度の26.9%から 14.3ポイント増加しています。※1

生成AIを導入する企業は「コスト削減」や「業務効率化」を期待するケースが多いですが、実際には「導入したものの効果が測定できない」「PoCで終わってしまった」という企業も少なくありません。導入の成功と失敗を分ける要素として下記3つがあげられます。

ROI(投資対効果)圧力の高まり

近年は、経営層がAI導入の費用対効果(ROI)を厳しくチェックする傾向が強まっています。

「何をどのくらい改善したのか」を数値で証明できないと、プロジェクトの継続や拡大が難しくなるため、 ROIを明確に設計し、可視化する仕組みが求められています。

規制強化と社会的リスクの顕在化

2025年に入り、EU AI Act(AI規制法)や日本国内の生成AIガイドラインの整備が本格的に行われるようになりました。

この動きにより、企業は以下のような対応が求められます。

- 透明性の確保(なぜこの出力になったか説明可能か)

- 利用データの管理(個人情報・機密情報の取り扱い)

- 著作権・倫理への配慮(出力物の権利と責任の明確化)

規制に違反した場合、社会的な信用リスクや訴訟のリスクがあり、「とりあえず使ってみる」は危険です。各ツールの利用規約や法律は更新され続けているため、こまめに確認しましょう。

LLMOps(大規模言語モデルの運用管理)未整備

生成AIの導入はPoC(実証実験)まではうまくいっても、本番運用でつまずく企業が非常に多いのが現状です。

その要因の1つが「LLMOps=生成AIの運用と監視の仕組み」が整っていないことにあります。

- モデルの出力を誰がどう評価・改善するかが決まっていない

- 利用ログが残らず、ハルシネーションや誤出力が放置されている

- 学習データやプロンプトの改善が属人的・場当たり的になっている

こうした状態では、導入効果が安定せず、継続的な改善が困難になり、生成AI導入の失敗につながります。

なお、AIプロジェクトについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

失敗パターン13選

「導入すれば何とかなる」と楽観視した結果、思わぬ落とし穴にハマるケースが少なくありません。企業の導入現場で実際に見られる失敗の例を13項目に整理しました。それぞれのリスクと注意点を解説します。

戦略・目的が曖昧なままPoCを開始

生成AIの活用目的が明確でないままPoCを始めてしまうと、効果検証ができず、業務課題と結びつかなくなります。「何のために使うのか」が現場で理解されず、結局使われなくなるケースも少なくありません。生成AIを導入する目的を明確にできるかどうかが成功の分かれ目です。

ガバナンス/セキュリティ体制が未整備

情報管理ルールがないまま生成AIを使うと、社内機密や個人情報が漏洩するリスクが高まります。特にAPI連携や外部クラウドサービスの使用時には、権限管理やログ監査体制を整えることが不可欠です。責任所在が不明確な状態では事故時の対応も困難になります。

利用データに著作権・プライバシーのリスク

生成AIが学習や出力に使用するデータに、著作権や個人情報が含まれていると、法的トラブルに発展する恐れがあります。適切なデータの取り扱い基準を設け、第三者の権利を侵害しないプロンプト設計や出力内容のレビューが必要です。

ROI指標を決めず「費用対効果不明」

「とりあえず導入」でスタートしてしまい、成果をどう測るかを定めていない企業が多く見られます。ROI(投資対効果)の目標がないままでは、経営層への説明ができず、継続判断ができません。導入前に数値化されたKPのI設定が不可欠です。

モデルの判断基準がブラックボックス化

生成AIを管理する者が、生成AIの出力結果に対して「なぜそうなったのか」を説明できず、問題に対応できなくなることがあります。特に専門性の高い業務で誤出力があると、現場の信頼を失い活用が進みません。透明性や、現場の人が理解できるような出力の根拠を示す仕組みが求められます。

ハルシネーション対策が不十分

生成AIは事実ではない情報を正確であるかのように出力するハルシネーションという特性があります。生成された誤情報が社内外に使用されると、会社の信頼を失ったり、業務ミスにつながったりするため、出力の検証フローや、人のチェックを前提とした運用設計が必要です。

運用・監視の体制が不在

導入後の継続的な監視体制がないと、想定外の出力や誤動作に気づけず、問題が表面化したときには手遅れになることもあります。生成AIの特性を理解し、ログの記録・定期レビュー・改善サイクルを含むLLMOps体制の構築が欠かせません。

ユーザーへの浸透・活用が定着しない

ツールだけ導入しても、現場に使われなければ意味がありません。操作方法が難しかったり、業務フローに組み込まれていないと、利用されなくなります。導入と同時にユーザー教育と活用支援を行うことが重要です。

出力結果にバイアスが含まれ、倫理的問題を招く

AIがもともと偏った内容を多く含むデータを学習していると、その偏りを引き継いだ回答や表現をしてしまう可能性があります。差別的表現や不適切な出力が発生することもあり、企業ブランドの毀損や倫理的批判を招くかもしれません。出力の監視・制御と、使い方ルールの整備が求められます。

ベンダーロックインによる柔軟性欠如

特定のツールやクラウドベンダーに依存しすぎると、コスト増や切替困難といった問題が発生します。

自社のデータやプロンプト設計が外部依存になると、自由にカスタマイズができなくなります。特定の1社だけに依存せず、複数のベンダーを組み合わせて使い、API連携の柔軟性を検討することが大切です。

MLOps/LLMOpsの理解・実践不足

生成AIは一度導入したら終わりではなく、継続的な評価・改善・監視が必要です。しかし、MLOpsやLLMOpsに関する知識や仕組みがないと、特定の個人に依存して業務が成り立っている状態になります。定期的な出力評価・チューニング・障害対応を組み込んだ設計が重要です。

社内教育・トレーニングが追いつかない

現場の活用力は、導入成果に直結します。ツールの使い方だけでなく、プロンプト設計の基本や出力の見極め方を教育しないと、誤用や誤信による事故リスクが高まります。リテラシー教育の継続と、問い合わせ対応の体制づくりが必要です。

「万能ツール」と過信しスコープを逸脱

生成AIはあくまで補助ツールであり、全てを自動化できるわけではありません。期待値が高すぎると、目的外利用が横行し、トラブルやリソースの浪費につながります。導入範囲と役割を明確に定めた上での活用が必要です。

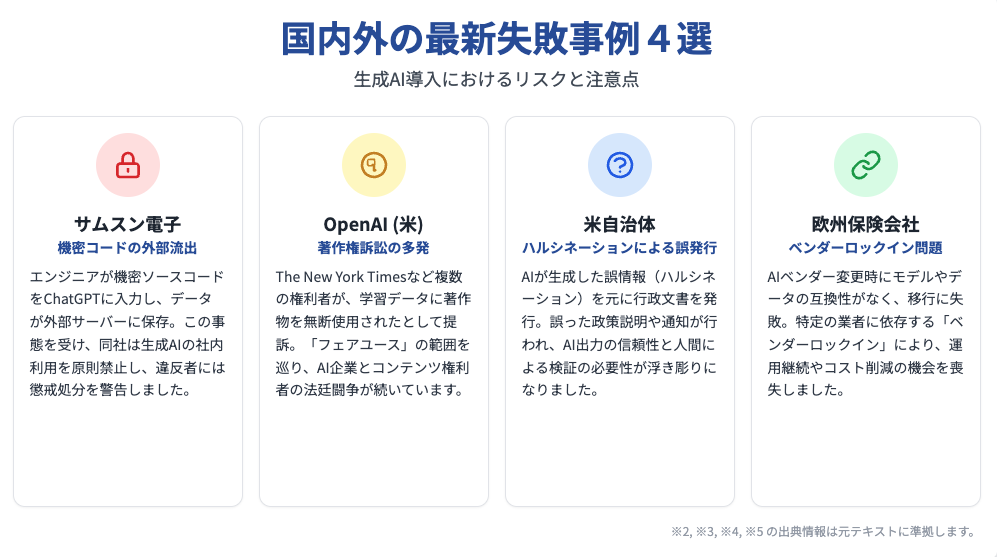

国内外の最新失敗事例4選

実際にどのような失敗事例があるのでしょうか。ここでは生成AIの導入に失敗した事例を4つご紹介します。

サムスン電子:ChatGPT利用による機密コードの外部流出

2023年、サムスン電子のエンジニア数名が社内の機密ソースコードや社内会議資料を ChatGPT に入力した結果、これらのデータが OpenAI のサーバーに保存されてしまいました。この事態を受け、同社は社用端末やネットワーク上での ChatGPT や他の生成AIツールの利用を禁止し、違反する社員には懲戒処分の可能性があると警告しています。現在、安全なAI活用環境の構築に取り組んでおり、自社内での専用AI開発も進められていると報じられています。※2

OpenAI(米):生成物に関する著作権訴訟の多発

2025年には、The New York Timesやその他複数の出版社・著作家がOpenAIおよびMicrosoftを相手取り、ChatGPTやCopilotの学習データに無断で著作物を使用したとして著作権侵害訴訟を提起しました。裁判は統合され、多数の訴訟が進行中です。原告側は「フェアユースを超える利用」であると主張しており、AI企業とコンテンツ権利者の間で法的対立がなされています。※3

米自治体:ハルシネーションによる誤った行政文章発行

アメリカでは、AIが生成した誤情報(ハルシネーション)をそのまま行政文書として発行し、誤った政策説明や住民向け通知が行われた事例が報告されています。複数の連邦裁判所では、AIによる誤った引用や虚偽記録が訴訟対象となり、出力の信頼性と検証機能の必要性が改めて浮き彫りになりました。※4

欧州保険会社:ベンダー変更時にモデル・データの引き継ぎが不可

欧州の保険業界では、AIベンダー変更時に生成モデルや学習データの互換性がなく、スムーズな切替ができなかったケースがあります。これはベンダーロックインによって、契約変更に失敗し、運用継続やコスト削減の機会が失われる典型的な障壁として指摘されています。EUのData Actでは、このような「データポータビリティ確保」の義務化が議論されています。※5

なお、著作権問題について詳しく知りたい方は、下記の記事を合わせてご確認ください。

失敗リスク別セルフ診断チェックリスト

生成AIの導入にあたっては、段階ごとに異なるリスクが潜んでいます。

本章では、「導入前」「PoC」「本番運用」の3フェーズに分けて、よくある落とし穴をセルフチェック形式で可視化できるリストを紹介します。

導入前フェーズ

本格導入の前に、戦略や社内調整が不十分なまま進めると、PoCの段階でつまずく可能性が高くなります。

以下の項目がクリアできているかを確認しましょう。

- 導入の目的・KPIが明文化されている

- 経営層との合意形成ができている

- 業務棚卸を実施し、AI適用領域を整理済み

目的と範囲があいまいなままの導入は、失敗につながります。まずは内部での認識統一と活用計画の設計が重要です。

PoCフェーズ

PoC(実証実験)の段階では、検証のための指標やセキュリティ対策が十分でないと、正しい判断ができません。

以下の項目を確認してください。

- 効果検証指標(定量・定性)が設定されている

- ハルシネーションやセキュリティ対策を考慮済み

- 利用ガイドラインが社内で共有されている

「とりあえず試す」のではなく、成果をどのように測り、どう守るかの準備が成否を分けます。

本番運用フェーズ

運用が始まった後も、放置されたままではリスクが蓄積されます。

継続的な監視と支援の体制が構築できているかを確認しましょう。

- LLMOpsの監視・改善体制がある

- 利用ログや出力内容のレビューが定期的に行われている

- 利用者への教育・サポート体制が継続されている

導入後こそ改善と定着が大切になります。仕組みと人の両面から運用を支えましょう。

失敗を防ぐ5ステップアプローチ

生成AI導入の失敗を防ぐには、単に技術を試すだけでは不十分です。目的設定から運用・教育まで、5つの段階で戦略的に進めることで、成果とリスクの両方をコントロールできます。

1. 目的定義と業務棚卸

生成AIは「何となく便利そう」では成功しません。まずは「なぜ導入するのか」「どの業務に使うのか」を明確にし、社内の業務プロセスを棚卸しましょう。属人的なタスクや文書作成、問い合わせ対応など、生成AIが向いている領域とそうでない領域を整理することで、PoCや本導入の効果を最大化できます。目的が曖昧なまま進めると、現場の混乱や費用の無駄に繋がります。

2. 小規模検証とROI試算

PoC(小規模な実証)では、ユースケースごとに導入効果を見極めることが大切です。改善される業務時間、精度、人的コストなどを数値化し、ROI(投資対効果)をシミュレーションしましょう。いきなり全社導入するのではなく、部門単位や特定業務から始めることで、現場での受容性や技術的な課題を早期に発見できます。小さく試して、大きく育てる戦略が有効です。

3. セキュリティ・ガバナンス設計

生成AIの導入には、情報漏洩や著作権侵害といったリスクがつきものです。これらを未然に防ぐには、社内ガイドラインの整備と、管理体制の構築が欠かせません。入力してはいけない情報の定義、出力物の取り扱い、利用ログの保存などをルール化し、従業員にも明確に伝えることが必要です。ガバナンスが曖昧なまま運用を始めると、予期せぬトラブルを招く恐れがあります。

4. LLMOps運用と監視体制の構築

PoCの成功後、本番運用でつまずく要因のひとつが、LLMOps(生成AIの運用管理)が整っていないことです。AIの答え方のくせや動き、出力結果を継続的にモニタリングし、改善サイクルを回す仕組みを整えましょう。

定期的なレビューや障害対応、チューニングの仕組みがないと、AIの信頼性が低下し、利用停止や炎上リスクにも繋がります。導入後の持続可能な活用のための体制づくりが重要です。

5. リテラシー教育と定着支援

生成AIの導入効果を高めるには、利用者自身がAIの特徴や使い方を理解している必要があります。初期研修だけでなく、定期的なアップデートやプロンプトのコツの共有、FAQ整備などを通じて、現場での活用を後押ししましょう。

また、利用ログの分析から「使われていない理由」を特定し、サポート体制やUIの改善につなげることで、社内浸透と継続利用が実現します。

成功事例に学ぶ業界別ベストプラクティス

生成AI導入においては、業界ごとに異なる課題を抱える中で、適切なユースケースと設計によって大きな効果を上げている企業があります。以下に、各業界の代表的な事例を紹介します。

製造業:手順書の自動生成による現場業務の効率化

RICOHでは、製造現場の業務効率化を目的に、生成AIを活用した作業手順書やマニュアルの自動生成・更新に取り組んでいます。※6

作業ログや音声データなどの現場情報をもとにAIが内容を自動で構成し、各現場に迅速に展開することで、情報共有のスピードが向上し、マニュアル整備にかかる時間とコストを大幅に削減しました。また、個人の経験に頼っていた作業方法を全員が共有できるようになり、品質の均一化と人為ミスの削減を同時に実現しています。

建設業:レンダリング作業の自動化で設計プロセスの効率化を実現

株式会社mign(マイン)は、建築・ランドスケープ設計(公園・庭園・広場・歩道・住宅地の外構(がいこう)など、屋外空間をデザインすること)におけるレンダリング工程を画像生成AIで自動化する支援サービスを2023年7月にリリースしました。※7

建設やランドスケープ設計の現場では、図面や3Dモデルを作成した後に、専用のレンダリングソフトで写実的なイメージへと仕上げる作業が必要です。しかし、図面に変更があった場合は、レンダリング工程を一からやり直す必要があり、設計者にとって大きな負担となっています。

こうした課題に対し、設計用の画像をアップロードするだけで、AIが自動的に写実的な完成イメージを作成してくれる画像生成ツールが登場しました。従来手作業で数時間かかっていたレンダリングが、5〜10分で完了するようになり、図面修正にも即座に対応可能です。

またこの技術により、プレゼン資料の作成や設計検討のスピードが大きく向上し、設計者の負担軽減と業務効率化の両立が実現されています。今後は中小規模の設計事務所にも広く普及が見込まれており、建設業界のワークフローを根本から変える取り組みとして注目されています。

金融業:FAQ自動応答・ナレッジ検索で24時間対応体制の実現

SBI証券や武蔵野銀行が導入したAIチャットボット(例:「KARAKURI chatbot」※8)は、24時間365日の自動応答を可能にし、顧客満足度の向上と有人対応の削減に成功しました。問い合わせ対応の定型化と迅速化により、カスタマーサポート業務の効率化と品質均質化が達成されています。

小売業:販促コピー生成によるスピードと反応率の向上

TRIAL Holdingsは、リテールAI研究会と連携し、商品情報共有基盤「J-MORA」の開発に生成AIを活用しました。※9

これまで製造・卸・小売の各社が個別に行っていた商品情報の登録業務は、表記ゆれや入力ミス等が非効率的で課題となっていました。そこで今回導入された仕組みは、生成AIがJANコードなどの商品データをもとに、商品名やカテゴリなどの不足情報を自動生成します。加えて、RPAと連携することで、生成された情報をスムーズに登録・更新が可能です。

従来3日かかっていた処理が1日以内に短縮されるなど、業務効率化とデータ品質向上を同時に実現しており、生成AIの実践的な成功事例として注目されています。

教育機関:レポート・テストの自動採点+フィードバック提供

教育現場での生成AI活用例として、名古屋市などで導入されたAI-OCR採点や記述式採点システムがあります。※10

答案データをスキャンし、AIが内容・構成・文法ごとに自動採点・添削。教員の採点負担が大幅削減され、生徒へのフィードバックも迅速化しました。教育の質向上と業務効率両立に貢献しています。

なお、生成AIの導入事例について詳しく知りたい方は、下記の記事を合わせてご確認ください。

2025年以降に備える最新トレンド&規制動向

生成AIのビジネス活用は急速に拡大を続けていますが、それに伴い法規制や技術トレンドの変化にも注意が必要です。特に2025年以降は、規制の明確化と高度化する活用ニーズの両方に対応する姿勢が求められます。ここでは、企業が押さえておくべき4つの重要トピックを紹介します。

EU AI Act:高リスクAIへの規制が義務化へ

EUでは「AI法(EU AI Act)」が2024年に成立し、2025年から段階的に適用されます。※11

この法律では、生成AIを含む「高リスクAI」に分類されるシステムに対し、記録保持・透明性・人による監視可能性・安全性確保などの要件を義務化されました。企業は技術要件だけでなく、倫理的・法的リスクへの備えも強化する必要があります。

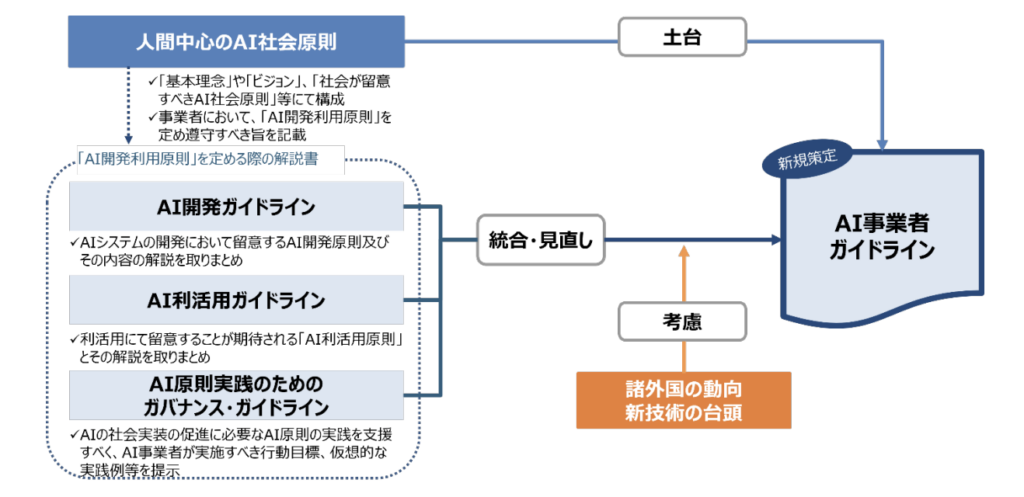

国内AI戦略:生成AIガイドライン(β)の公開予定

2024年4月、経済産業省と総務省は共同で「AI事業者ガイドライン(第1.0版)」を策定・公表しました。※12

このガイドラインは、生成AIをはじめとするAI技術の適正な利活用を促進するため、民間企業や開発者が遵守すべき原則やリスク管理の枠組みを示したものです。

主なポイントをまとめました。

- 透明性・説明責任の確保:AIの判断根拠や出力内容が理解可能であること

- 安全性とセキュリティの担保:不正アクセスや情報漏洩への対策を設計段階から考慮

- 人間中心の価値実現:AIによる判断が人間の尊厳や自由を侵害しないよう配慮

- 公平性・非差別性の確保:バイアスの回避、アルゴリズムの検証体制の整備

- 利用者との適切な関係構築:利用規約の明示、リスクに関する適切な説明

また、本ガイドラインは今後もアップデートされる予定であり、生成AIガイドライン(β)として先行的に運用しつつ、パブリックコメントや有識者委員会での議論を通じて改善が加えられていきます。

企業にとっては、このガイドラインを踏まえた社内ポリシー・契約書類・開発体制の見直しが重要です。

特に、AIの出力結果に対する責任所在の明確化や、ユーザーへの適切な説明対応が、2025年以降の法的・社会的信頼確保の鍵となるでしょう。

マルチモーダル×業務特化:複合データを活かすAIが急成長

画像・音声・センサーデータ・テキストといった複数の情報を組み合わせて処理する「マルチモーダルAI」の実用化が進んでいます。特に製造・医療・カスタマーサポートなどの分野では、業務に特化した形でマルチモーダルAIを導入し、より高度な判断や支援を実現する動きが加速するでしょう。生成AIの活用はテキストだけにとどまらない段階に入っています。

「社内LLM」活用の加速:リスク低減と精度向上を両立

外部の大規模言語モデル(LLM)をそのまま使うのではなく、自社内の文書・ナレッジ・FAQを学習させた社内特化型LLMの活用が広がっています。これは、情報漏洩リスクを最小化しながら、業務内容に合致した高精度な応答や判断が可能です。

オンプレミス環境やプライベートクラウド上での構築も選択肢に入るなど、カスタマイズ性と安全性のバランスを重視した導入が注目されています。

このように、生成AIの導入においては「技術の進化」と「規制の強化」が同時に進む局面に入っています。企業としては、単なる活用にとどまらず、社会的責任や情報倫理を意識した運用体制の整備が不可欠です。

生成AI導入を成功させよう

生成AIは、業務効率化や競争力向上の切り札として多くの企業で導入が進んでいます。今回は生成AIの導入で失敗しないためのポイントをご紹介しました。

生成AIの導入を成功させるには、次の3つのポイントが特に重要です。

- 目的とROIを明確にし、効果を測れる形で始めること

- ガバナンスやセキュリティなど、リスク対策を事前に整える

- PoCだけで終わらせず、LLMOpsを含む運用体制を整備する

さらに、2025年以降の国内外におけるAI規制(EU AI Act、AI事業者ガイドライン)や、マルチモーダル・社内LLMといった最新トレンドも押さえておきましょう。

結論として、生成AIの導入で成果を上げるには、「やってみる」から「仕組みを作る」への意識転換が欠かせません。今回紹介したポイントを参考に、まずは自社の状況を一度整理してみることから始めてみてください。

生成系AIの業務活用なら!

・生成系AIを活用したPoC開発

・生成系AIのコンサルティング

・システム間API連携

最後に

いかがだったでしょうか?

導入目的やKPIが曖昧なままでは、生成AIはむしろリスクになります。失敗を防ぐ戦略設計が不可欠です。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。 ︎株式会社WEELのサービスを詳しく見る。

︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。 ︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。

※1:生成AI の利用状況(「企業IT 動向調査2025」より)の速報値を発表

※2:Samsung Bans ChatGPT Among Employees After Sensitive Code Leak

※3:Judge allows newspaper copyright lawsuit against OpenAI to proceed | AP News

※6:Generative AI in Manufacturing, Transforming an Industry | Ricoh USA

※7:画像生成AIによってパースのレンダリング(写実的な表現に変換)を即座にできるソリューションをリリース

※8:困りごとや疑問にも24時間対応、顧客思いのAIチャットボットサービスを実現

※9:“年間36億回”の工数削減を目指す 「J-MORA」で競合の垣根を超えた物流改革へ(後編) | トライアルホールディングス

※10: AI技術で学校のテストを採点 名古屋市立の全ての中学と高校でシステム導入へ 一足先に導入した中学校を取材したら… | 名古屋・愛知・岐阜・三重のニュース【CBC news】

※11:EU AI Act

【監修者】田村 洋樹

株式会社WEELの執行役員として、AI導入支援や生成AIを活用した業務改革を中心に、アドバイザリー・プロジェクトマネジメント・講演活動など多面的な立場で企業を支援している。

これまでに累計25社以上のAIアドバイザリーを担当し、企業向けセミナーや大学講義を通じて、のべ10,000人を超える受講者に対して実践的な知見を提供。上場企業や国立大学などでの登壇実績も多く、日本HP主催「HP Future Ready AI Conference 2024」や、インテル主催「Intel Connection Japan 2024」など、業界を代表するカンファレンスにも登壇している。