- AI技術で他人そっくりの顔や声を再現できる「ディープフェイク」が社会問題化

- 悪用による名誉毀損・フェイクニュース・なりすまし被害が国内外で急増中

- 企業や個人がとるべきリスク対策・検出技術・法制度の動向もあわせて解説

生成AIの進歩が目覚ましいですが、それと合わせて「ディープフェイク」という言葉がよく聞かれるようになりました。

ディープフェイクは便利で生活を豊かにしてくれる技術ですが、使い方を間違えてしまうと大きな被害や損害が出てしまう可能性もあります。アプリやツールを使えば誰でも簡単に使えてしまう分、自分自身が被害者や加害者になってしまうかもしれません。

本記事では、ディープフェイクとはどういうものなのか、また見分ける方法や対策などについて詳しく解説します。

ディープフェイクの知識を身につけ上手に活用するために、ぜひ最後までご覧ください。

ディープフェイクとは

ディープフェイクとは、AIの深層学習技術を活用して、実在する人物の顔や声を模倣した偽の映像・音声・画像を作り出す技術です。近年ではSNSや動画投稿サイトを通じて急速に拡散し、フェイクニュースやなりすまし、詐欺など悪用事例が相次いでいます。

まずは、ディープフェイクの仕組みや問題点を解説するので、基本的な知識から理解を深めましょう。

ディープフェイクの意味と語源

ディープフェイク(Deep Fake)は、人工知能(AI)技術を使用して実在する人物の顔や声を非常にリアルに模倣した偽のビデオやオーディオクリップを作成する技術です。

ディープフェイクの語源は、「Deep Learning(深層学習)」と「Fake(偽物)」という2つの言葉を組み合わせた造語です。

ディープフェイク技術は娯楽や芸術の分野でポジティブな用途もありますが、偽ニュースの拡散・政治的な操作・詐欺・プライバシーの侵害など、様々な悪用の可能性も指摘されています。

特に公人の言動をねつ造したり、個人の同意なくプライベートな映像を作成するなど、倫理的・法的な問題を引き起こすケースが増えています。

ディープフェイクの仕組み

ディープフェイクには、GAN(Generative Adversarial Network、生成敵対ネットワーク)と呼ばれる技術が使われています。GANは、2つのAIを競わせることで、非常にリアルな画像やビデオを生成する技術です。

一方のAI(生成するAI)は本物そっくりのデータを作り出そうとし、もう一方のAI(監視するAI)はそのデータが本物か偽物かを見分けようとします。この競争を通じて、生成する側のAIは、次第に本物と見分けがつかないほど高品質な偽物を作り出すようになります。

ディープフェイクの問題点

ディープフェイク技術は、上手く活用すればクリエイティブな表現の可能性を広げられる、労働を軽減できるといった様々なメリットがあります。一方で、悪用された場合に周囲に与えるリスクが非常に高いことは大きな問題となっています。

ディープフェイク技術の発展はめざましく、現在では本物と見分けがつかないほどリアルで精巧です。この技術が悪用された場合、その影響は計り知れません。

「ディープフェイクの悪用事例」でもご紹介したように、政治家の発言をねつ造したフェイク動画が拡散されれば、選挙や政治に重大な影響を及ぼしかねません。また、ディープフェイクポルノが拡散されれば、深刻なプライバシー侵害かつ被害者に計り知れない精神的苦痛を与えます。

またディープフェイク技術が高度化し広く一般に普及することで、「真実」の概念そのものが揺らぎ、人々の現実に対する信頼が損なわれる可能性もあるでしょう。

生成AIの登場と発展によって私たち人間の利便性が向上すると同時に、ディープフェイクの脅威に対抗するための法的・技術的な対策が急務となっています。

ディープフェイクの良い活用事例9つ

生成AIやディープフェイクの技術は、上手に活用すれば人々の暮らしをより豊かなものに変えてくれます。ディープフェイクが実生活の場面でどのように使われているのか、具体的な事例を見ていきましょう。

AIアナウンサー

ディープフェイク技術により、リアルなCGキャラクターがAIアナウンサーとしてニュース原稿を読み上げることも可能です。

中国のニュース番組「杭州新聞聯播」は、中国の大型連休である「春節」の期間中、すべてAIアナウンサーによりニュース番組を放送するという試みをしました。そうすることで、本物のアナウンサーたちが今まで不可能だった大型連休の帰省ができたそうです。※1

日本の地上波番組でも、テレビ朝日の先輩アナウンサーの顔や声を基に作られた「花里ゆいな」がニュースを読んでいるのをご存じの方も多いのではないでしょうか。

こちらの動画はデビュー当初の映像なので、表情や音声に違和感を抱く人も多いと思います。しかし、現在では生成AIの急成長により、AIアナウンサーの表情や身振りはより一層人間味を増して自然なものになっています。

本物の人間なら読み間違いや言い間違い、余計な間投詞が入ることもありますが、AIアナウンサーであればそういった問題もなくなりますね。

また、突発的なニュースにもすぐに対応できたり、24時間ニュースを報道できるようになったりといったメリットもあります。

映画・CG制作

ディープフェイク技術は、映画制作などエンターテインメント業界でも活用されています。リアルなCGキャラクターの生成、故人の映像の生成、俳優を若返らせるなど、創造的な用途で使用可能です。

実際に、マーティン・スコセッシ監督の映画「アイリッシュマン」では、ディープフェイク技術を活用して俳優のロバート・デ・ニーロを若返らせました。

ディープフェイクを活用することで、全く違和感なくデ・ニーロが若かりし頃の姿で再現されています。ディープフェイクの技術により、視覚的なリアリズムを追求し、ユーザーに新しい体験を提供することが可能になりました。

多言語への吹き替え

ディープフェイク技術を活用することで、多言語への吹き替えがより自然に行えるようになりました。

映像内の人物が実際に異なる言語を話しているかのように口の動きを調整することで、視聴者は映画特有の違和感である「リップシンク(口の動きとセリフ・歌などの音声が、同期している状態)のズレ」を感じることなく、映画や番組を楽しめるでしょう。

吹き替えによる言語の壁をなくせれば、世界中のさまざまな言語話者に向けてコンテンツを発信できます。

故人をよみがえらせる

ディープフェイク技術を活用して、亡くなった俳優や有名人を映像の中でよみがえらせるという動きも存在します。

自動車事故で亡くなった俳優ポール・ウォーカーの、映画「ワイルドスピード」の未完成シーンをディープフェイクで完成させたことは特に有名ですね。

ディープフェイクは、人物だけでなく声の再現も可能です。

米国の有名司会者であるアンソニー・ボーディンさんの半生を描いたドキュメンタリー映画「Roadrunner: A Film About Anthony Bourdain」では、故人が手紙の中で残した言葉がディープフェイク技術により本人の音声として再現されています。※2

日本では、1989年に亡くなった歌謡界の女王・美空ひばりをデータ上で再現するという取り組みをNHKが行いました。AI技術を用いて本人の歌声を再現し、さらにCGで作成された「AIひばり」も登場。賛否両論はありましたが、映像の中でよみがえる美空ひばりにファンからは感動の声が多く集まりました。※3

バーチャル試着

ディープフェイク技術は、洋服選びや試着の場面でも活用が進んでいます。

バーチャル試着は、「実際に試着できないためにイメージがつかみにくく、購入に至りづらい」というオンラインショッピングの問題点を解決するためのサービスです。このサービスの先駆者である「Zeekit」が登場して以降、多くの企業がバーチャル試着のサービスに参入しています。

バーチャル試着の仕組みは、ユーザーがアップロードした自分自身の画像をAIが解析して3Dモデルを構築し、実際の着用時に近いイメージを生成するというものです。

ユーザーは自分がどのように見えるかをリアルに把握でき、サイズ間違いをなくすだけでなく、似合うカラーや形状なども第三者目線で把握できるようになりました。

バーチャル試着の導入によって、サイズ違いによる返品率の減少と、購買率がアップするという効果も報告されています。※4、※5

オンラインショッピング時の不確実性を減らし、より満足度の高い購入体験を実現できるようになったことで、バーチャル試着はファッション業界においても欠かせない技術となっていますね。

AIインフルエンサー

AIインフルエンサー(バーチャルインフルエンサー)は、SNSや動画サイトなどで情報を発信するAIで生成されたバーチャルヒューマンのことです。

AIインフルエンサーを起用することによって、企業は完全にコントロール可能なインフルエンサーを使って一貫したブランドメッセージを発信できるというメリットがあります。

さらに、AIインフルエンサーは年中無休で活動できるため、ターゲットオーディエンスと常に接触し続けられるという点も大きなメリットですね。

すでに日本でも多くのAIインフルエンサーが活躍しています。AIインフルエンサーの「imma(Instagramフォロワー数39.2万)」はリアルの有名人とコラボしたり、製品の着用イメージを投稿するなど様々な活動で人気を博しています。

患者の声を取り戻す

ディープフェイク技術は、医学分野でも活用されています。

たとえば、脳卒中やALSなどで声を失った患者のために、合成音声を生成可能です。

この技術では、既存の音声データをモデルに学習させ、患者の声質に近い音声を生成します。さらに、特定の言語や方言にも対応し、より自然な話し方ができる音声を生成できます。

過去に録音がない場合でも、個人に合わせた音声を作れるのが大きな魅力ですね。

この動画の撮影時点ではまだ不自然な音声ですが、生成AIの進化によって近い将来、より自然な患者本来の声を再現できるようになるでしょう。

教育分野での活用

歴史的人物の映像や音声をリアルに再現することで、学生たちに直接語りかけるような、臨場感のある学びを得られるツールとして活用されています。

たとえば、アインシュタインそっくりの人物と会話しながら、相対性理論を学ぶといった使い方がすでに実用化されています。※7

ファッションブランドのPR

ドイツ発のEC大手 Zalando は、モデルCara Delevingneの顔をディープフェイクでローカライズした広告を12カ国で展開し、1億8000万回以上のインプレッションを獲得しました。※18

生成AIによって言語や文化に合わせた動画を量産し、高精度なパーソナライズ広告を実現できたのは、まさにディープフェイクだからこその成果と言えるでしょう。

なお、ディープフェイクツールの検証について詳しく知りたい方は、下記の記事を合わせてご確認ください。

ディープフェイクの悪用事例6つ

ディープフェイクは上手に活用すればとても便利な技術ですが、悪用すれば大きな被害を発生させてしまう可能性もあります。世界ではすでに、ディープフェイクを悪用する事件も出てきているため、悪い活用法も把握して被害を受けないよう気をつけましょう。

「オレオレ詐欺」のように事前に知っておくことで、自分の被害を防げる可能性もあります。

具体的な事例をご紹介しますので、ぜひ参考にしてください。

著名人のフェイクニュース

まず懸念されるのが、ディープフェイク技術によって作成されたフェイクニュースです。フェイクニュースの作成に悪用されると、公共の人物が実際には言っていない発言や行動をリアルに見せかけることが可能になり、誤情報が広まって多くの人々に影響を与える可能性も出てくるでしょう。

ディープフェイクによるフェイクニュース問題は特に海外が顕著です。

2022年3月に出回ったディープフェイクでは、ウクライナのゼレンスキー大統領になりすました人物が、ロシア軍への抵抗をやめるよう国民に呼びかける動画が出回りました。ディープフェイクの技術を使えば影響力のある人物になりすまし、政治的な発言をさせることで混乱を作り出すこともできてしまいます。

※6日本でもX(旧Twitter)で、民放のニュース番組を装いアナウンサーが投資を呼びかける動画や、岸田総理大臣が卑わいな内容を話している動画が相次いで投稿され大きな問題になりました。※8

ディープフェイクによるフェイクニュースは数年前から出てきていましたが、生成AIの登場によって、特別な知識や技術なしで本物と見分けがつかないほど精巧な動画を誰でも簡単に作れるようになってしまいました。

フェイクニュースは社会的な混乱を引き起こし人々の信頼や政治的安定性を損なうため、ディープフェイクの技術的な進歩とともに、これに対する警戒と対策が急務とされています。

フェイクポルノ

ディープフェイクを用いたフェイクポルノも重大な問題の1つです。

ディープフェイク技術を使って、実在する人物の顔を無断でアダルトコンテンツに合成し、インターネット上に拡散する行為がフェイクポルノにあたります。

何気なくSNSに上げた思い出の写真や卒業アルバムがAI技術の悪用で裸の画像に加工されてばらまかれていた、というような事例が世界各地で明らかになり、社会を揺るがせています。

フェイクポルノ問題が最も深刻なのは韓国です。実際、韓国では知人女性や少女らの顔写真をディープフェイクで性的な画像に加工し、通信アプリのテレグラムで拡散される事件が起きました。※19

その次にアメリカでも増加傾向にありますが、日本も例外ではありません。

インターネットで出回る盗撮画像などのパトロールをしている団体「ひいらぎネット」によると、日本でもここ数年、さまざまなSNSで性的なディープフェイクが盛んに投稿されるようになったそうです。※9

アメリカのセキュリティー団体によると、2023年度にフェイクポルノの標的となった人の国籍調査では、日本は韓国・アメリカに次いで3番目に多いという結果でした。

このようなコンテンツは対象者の名誉を傷つけ、精神的な苦痛を引き起こす行為です。また、社会的な評価を低下させる可能性さえあります。公共の人物や一般人を問わず個人のプライバシー権と尊厳を侵害する深刻な犯罪行為とされ、法的な対策が急務と言えるでしょう。

音声なりすまし詐欺

イギリスでは、企業のCEOの声をディープフェイクで作成し、22万ユーロ(約2600万円)を騙し取られる事件が発生しました。

電話での指示は、AIによる音声技術を利用してCEOになりすました詐欺師からのものだったと考えられており、BBCは他にも同様の事件が確認されていると報じています。※10

他にも、ディープフェイクを用いて声紋・顔認証などの生体認証を不正に突破し、銀行口座を操作してお金を盗んだという事件も発生しています。※11

3秒間の音声データがあれば高精度で合成できることや、オープンソースの生成AIが増えたことで、誰でも簡単にAI音声の生成ができてしまうようになりました。

国内でこれほど認知されているにもかかわらず、電話によるオレオレ詐欺の被害額が2023年では前年より41.4億円増えて133.5億円になったことなどを考えると、今後日本でもAI音声による被害は拡大する可能性が高いかもしれません。※12

人物なりすまし詐欺

ディープフェイク技術の悪用によって、音声だけでなく人物そのものになりすました詐欺も発生しています。

攻撃者はディープフェイクを使用して信頼されている人物になりすまし、個人情報の窃取、金銭の詐取、さらには政治的な操作を目的として使用しています。

FBI(アメリカ連邦捜査局)は、就職のオンライン面接で別人になりすますなど、ディープフェイク技術の悪用が増えていると発表しました。

面接の最中に他人の映像・画像・音声などを自身に重ね合わせているという申し立てが増えているとのことで、著名人だけでなく、一般の人の情報も悪用される恐れが懸念されています。※13

また香港では、多国籍企業の財務担当者がビデオ会議で同社の最高財務責任者(CFO)になりすましたディープフェイク詐欺師にだまされて、約38億円を詐欺グループに送金した事件があります。

このビデオ会議には財務担当者以外の社員も参加していましたが、被害者以外はすべてディープフェイクによる合成でした。※14

見分けがつかないほど精巧に作られたコンテンツにだまされて重大な損害が発生する事例は、生成AIの発展とともに増加傾向にあります。このような詐欺やなりすましは、個人のセキュリティだけでなく、社会全体の信頼を損なうため警戒が必要です。

なりすまし広告詐欺

実在の著名人を装った偽の広告をSNSなどで表示し、ユーザーを偽のサイトに誘導して金銭をだまし取るケースも発生しています。

特に「SNS型投資詐欺」と言われる詐欺が横行しており、大手SNSのInstagramでは著名人のなりすまし広告が多数表示され、運営元のMetaが対応に追われていました。

ZOZO前社長の前澤さんが、なりすまし広告に対処する専門チームを立ち上げるなど個人での対策も取られているにもかかわらず、いまだに被害は出ているそうです。※15

ディープフェイクを使用して生成された著名人の音声や動画を本物と見分けることは難しく、このような偽の広告により投資話に勧誘される事例が日本でも多発しています。

サイバー攻撃

ディープフェイク技術は、巧妙ななりすまし詐欺や情報操作の手段としてサイバー攻撃に悪用され始めています。

例えば、銀行員になりすました音声ディープフェイクを使って企業に送金を指示する「ボイスBEC詐欺(音声版ビジネスメール詐欺)」などです。※21

このような脅威に対して、企業は技術面と教育面の両軸で対策を講じる必要があります。

具体的には、以下のような対策が有効です。

- 社内向けのなりすまし詐欺対策マニュアルの整備

- 定期的なセキュリティ教育・模擬訓練の実施

- 音声・映像の指示には本人確認プロセスを必ず挟む

- 外部サービスによるAIコンテンツ検知ツールの導入

企業規模や事業内容に応じて、適切な対策を検討しましょう。

なお、生成AI顔入れ替えツールのおすすめについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

ディープフェイクの検知・法整備の現状

ディープフェイクの検知や法整備に関しては、まだまだ追いついていないのが現状です。

日本と海外の法整備の違い

ディープフェイクに対する法整備は、国によって対応の進み具合が大きく異なります。

日本では2025年現在、ディープフェイクに特化した法律は未整備であり、現行の著作権法や肖像権、名誉毀損といった個別法で対応するにとどまっています。

例えば、AIが生成した画像に他人の顔を使った場合は、肖像権やプライバシー権の侵害として争われる可能性がありますが、技術的な判断や故意性の証明が難しく、対応に課題が残る状況です。

一方、ディープフェイクを検出する技術に関しては各国で研究が進んでいます。たとえば、DARPA(米国国防高等研究計画局)ではディープフェイク検出技術のプロジェクトに資金などの支援をし、2018年11月の時点で6,800万ドルの資金を投入しています。※16

また、アメリカ・カリフォルニア州ではディープフェイクに関する2つの法律(AB-730、AB-602)を、テキサス州では1つの法律(SB-751)をそれぞれ2019年に成立させました。しかし日本においては、現時点でディープフェイク自体を規制する法律はないため、判断が難しいところです。

逮捕事例においても、被害者側から「名誉毀損」と「著作権侵害」の罪を告訴後に容疑者2人が摘発されていることからも、まだまだ法整備が追いついていないことを物語っています。

性的ディープフェイクの規制強化の動き

ディープフェイクの中でも特に問題視されているのが、本人の同意なく作成・拡散される性的な偽造コンテンツです。

実際に日本国内でも、女性芸能人の顔を他人のヌード写真に合成した「フェイクポルノ」がSNSや掲示板に投稿され、刑事事件に発展するケースが報告されています。

こうした事件を受けて、こども家庭庁や有識者らによる作業部会は、違法な画像の削除の要請など対策を強化する方針を示しました。※20

具体的には、サイトの管理者への違法な画像の削除の要請を強化するほか、被害の実態把握などの対策を進めると公表しています。

ディープフェイクへの対策

悪用される恐れもあるディープフェイクですが、どのように対策すれば良いのでしょうか?

ディープフェイクへの対策は、個人での取り組みだけでなく社会的・組織的な対策が不可欠です。代表的な2つの対策を解説します。

ブロックチェーン

まずディープフェイク対策として有効と考えられるのが、ブロックチェーンです。ブロックチェーン技術は、デジタルコンテンツの作成と動きの履歴を、不変の記録として残します。これにより、画像や動画が元の形で作成された時点からの変更履歴を追跡でき、真正性を証明することが可能です。

ディープフェイクのような偽造コンテンツを識別しやすくなり、信頼できる情報源からのコンテンツであることを保証する手段となるでしょう。

C2PA

C2PAは、オンラインで「誤解を招く情報」のまん延に対処する技術標準化団体です。Adobe・BBC・Intel・Microsoft・ソニー・Googleなどが参画しています。

消費者やプラットフォームは、コンテンツが信頼できる情報源から来ているかを判断しやすくなり、ディープフェイクによる偽情報の拡散を防ぐ可能性が高まると期待されています。

なお、生成AIのセキュリティリスクについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

ディープフェイクを見分ける方法

ディープフェイクによる被害に遭わないよう、今すぐできるディープフェイクを見分ける方法をご紹介します。

法規制がまだ整っていない間は、自分自身で対策を取り自衛することが最も大切です。紹介するディープフェイクの見分け方をぜひ参考にしてください。

常に情報源をチェックする

ディープフェイクを見分けるためには、常に情報源をチェックすることが最も重要です。

まず、その動画や画像がどの情報源から共有されているかを確認しましょう。特にセンセーショナルな内容や驚くような発言が含まれている場合は、公式な報道機関やメディアが取り上げているかを確認することが重要です。

また、1つの情報源だけを信用してはいけません。信頼できると思っている情報源でも、必ず異なるアプローチを用いてクロスチェックする習慣をつけましょう。

公式声明や報道を確認できれば、コンテンツの信ぴょう性が高まります。

ディープフェイクの知識をつける

ディープフェイクを見破るためには、ディープフェイクについての知識を身につける必要があります。

ディープフェイクの自己学習に最適なのが、Microsoft・ワシントン大学・USA Today・Sensityが共同開発した「Spot the Deepfake」という自己学習コンテンツです。

このコンテンツでは、クイズ形式でディープフェイクを見破るポイントなどを紹介しており、気軽に学べます。ぜひチャレンジしてみてください。

ディープフェイク検知ツールを利用する

Microsoft、Sensity、Google、Metaなどがディープフェイク検出の技術開発に乗り出しており、すでに実用化されている検知ツールもあります。

日本でも、国立情報学研究所の研究チームがフェイク顔映像を自動判定するプログラム「SYNTHETIQ: Synthetic video detector」を開発しました。※17

このプログラムは大量のデータに基づく自動識別手法を採用しており、圧縮やデジタル信号で処理されたフェイク顔映像でも、一定の信頼度を保てると言われています。

また、Google ImagesやTinEyeといったツールを利用して、画像や動画の文脈を調べることも可能です。メディアが編集したものか、異なる文脈で以前に使用されていたかを確認できるので、こうした検索結果からコンテンツにおける改ざん有無や過去の共有状況を調べられます。

ただし、ディープフェイク技術の発展はめざましく、悪用する側と検出する側のイタチごっこ状態なのが現状です。検知ツールを使えば大丈夫というわけではありませんので、検知ツールはあくまでも補助的な役割として活用し、ソースの確認や精査を怠らないようにしましょう。

代表的な検知ツール・セキュリティ企業とその比較

| ツール名 | 料金 | 特徴 |

|---|---|---|

| Microsoft Video Authenticator | 非公開(法人向け) | 画像・動画のピクセル分析により真偽をスコア化。リアルタイム検知に対応。 |

| Deepware Scanner | 無料 | スマホ対応。簡易的な動画・音声フェイク検知ツール。精度は中程度。 |

| Sensity AI | 要問い合わせ | SNSなどの投稿を大規模解析。法人向けにレポート・検知APIを提供。 |

| Hive Moderation | API課金制(例1000リクエスト0.5ドル) | API組み込み可能。画像・動画の違法・フェイクコンテンツ検知に対応。 |

ディープフェイクのリスクが広がる中、検知ツールも進化を続けています。上記は代表的なツールとその特徴を比較したものです。

検知ツールを選ぶ際は、用途や予算、対応フォーマットを考慮することが重要です。特に法人利用では、API連携やレポート機能の有無も検討材料になります。

検知精度の限界に注意

ディープフェイク検知技術は年々向上しているものの、100%の精度は現時点では実現されていません。

AI技術の進化とともにフェイクの巧妙化も進んでおり、特に「低解像度」「短尺コンテンツ」「部分的加工」などのケースでは、検知ツールが見抜けない可能性もあります。

さらに、完全一致でない限り「フェイクかどうか」の明確な判断が難しく、誤検出や見逃しのリスクも存在します。

そのため、検知ツールだけに依存するのではなく、「発信元や文脈を確認する」「専門家によるダブルチェックを導入する」といった多層的な対策が推奨されます。

「自動+人の目」の併用こそが、現時点での最も信頼できる防衛策といえるでしょう。

ディープフェイクの作り方

ディープフェイクは、スマホアプリやPCソフトを使って誰でも簡単に作成できます。専門的な知識がなくても、基本的な操作を理解すれば作成可能です。

ここでは、スマホとPCそれぞれの環境でディープフェイクを作る方法をわかりやすく紹介していきます。

スマホでディープフェイクを作る方法

iPhoneやAndroidでは、専用のディープフェイクアプリを使って顔の入れ替えや映像の合成が手軽に行えます。

作成ステップを以下にまとめました。

- アプリをインストール

「Reface」や「FaceApp」など、人気のディープフェイク対応アプリをインストールします。

- 素材を選ぶ

自分の顔写真や使いたい動画素材を選択します。

- 顔を読み込む

アプリが自動的に顔を検出し、AIが合成処理を行います。

- 出力・保存

生成されたディープフェイクをプレビューし、気に入れば保存・共有できます。

なお、無料アプリでは機能制限やウォーターマークが付く場合があるため、利用規約や商用利用の可否は事前に確認しましょう。

PCでディープフェイクを作る方法

PCでは、より高度な編集や本格的な動画合成が可能です。

以下は代表的な作成手順です。

- ツールを導入する

「DeepFaceLab」や「Faceswap」などのオープンソースソフトをダウンロードし、PCにセットアップします。

- 素材を準備する

対象の顔写真や動画を複数用意し、AIに学習させるためのデータを揃えます。

- 学習モデルを生成する

顔を抽出し、アノテーションを行って学習用モデルを作成します。

- 顔を合成する

学習済みモデルを使って、対象映像にリアルな顔合成を行います。

- 動画を出力・編集する

合成済みの動画をエクスポートし、必要に応じて動画編集ソフトで微調整を行います。

PCでの作成は自由度が高い分、ある程度のPCスペック(とくにGPU性能)が必要です。本格的な映像制作や研究用途に向いています。

ディープフェイクが作れるアプリ・ツール

現在ではアプリやオンラインツールを活用して、簡単にディープフェイクを作成できます。難しい知識やスキルは必要なく誰でも使えるので、興味のあるツールはぜひ試してみてください。ただし、悪用はしないようにご注意くださいね。

xpression camera

「xpression camera(エクスプレッションカメラ)」は、Zoom会議などで自分の外見をAIで置き換えられるツールです。自分自身の外見をAI(人工知能)で置き換えて、表情や体の動きに応じてリアルタイムにコミュニケーションができます。

ZoomやTeams・YouTubeなどあらゆるビデオアプリ上で動作し、好きな画像一枚だけで、その人になりきれます。

DeepSwap

「Deepswap」は、顔交換ビデオ・写真・gifを生成するツールです。

現在では1.5億人以上のユーザーがfaceswapを作成しています。

Deepswapでは、最先端のAI faceswap技術を提供しており、高品質で理想的な顔を作成できます。動画制作をよりクリエイティブなものに変えてくれるツールですよ。

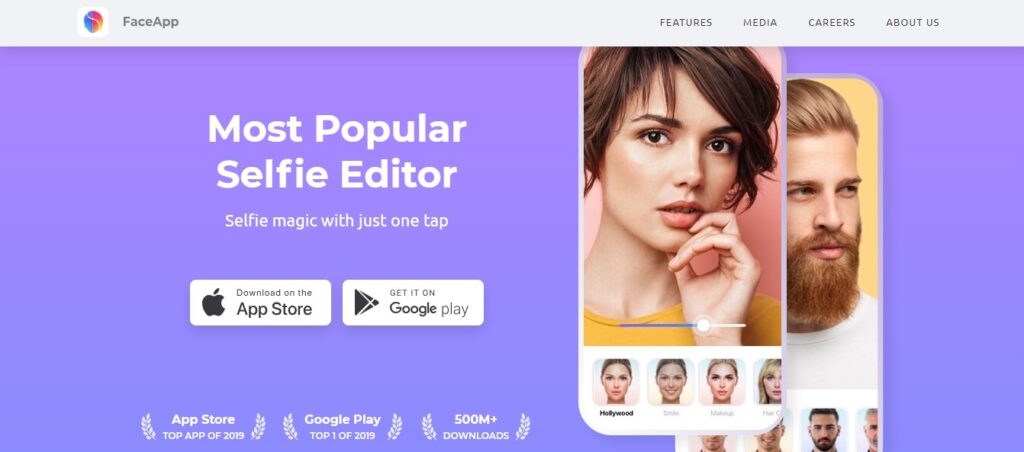

FaceApp

「FaceApp(フェイスアップ)」は、ロシアのWireless Labが開発したモバイルアプリです。

撮影した写真から性別・年齢・顔の印象・髪色など細かい部分を変えられたり、メイクもできるなど、手軽に自分の写真を変化させられます。

本格的に利用するなら課金が必要ですが、無料版だけでも様々な機能が使えます。使い方も簡単なので、ディープフェイク初心者の方にもおすすめですよ。

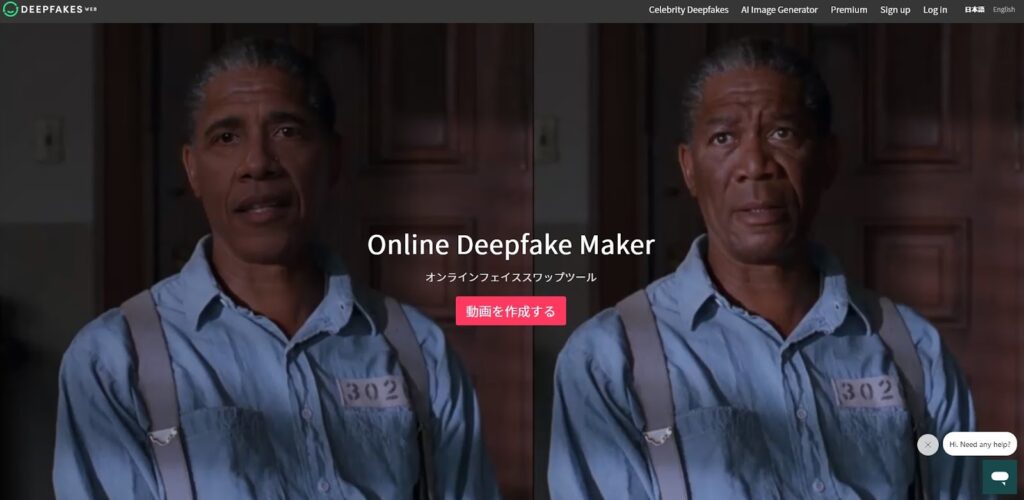

Online Deepfake Maker

「Online Deepfake Maker」は、オンラインでのみ利用可能なディープフェイク作成ツールです。

非常に精度が高く、本物の人間のようなディープフェイク動画を作れます。ディープフェイクに必要な処理は全てオンライン上で行われるためスマホからでも利用可能ですし、PCスペックが必要ないというのも大きなメリットです。

悪用対策として、作成されたディープフェイク動画には偽物だとわかる透かしが入ります。

ただし、利用するには1時間3ドルの費用がかかってしまうので注意してください。

Reface

「Reface」は、顔のみを識別して動画や写真の顔と入れ替えられるディープフェイクアプリです。

自分や友人の顔を切り抜いて、映画の俳優や有名人と入れ替えるということも簡単にできるので、おもしろ動画などを作るのにも使えそうですね。

本格的に利用するためには課金が必要ですが、基本的な編集は無料で利用できます。

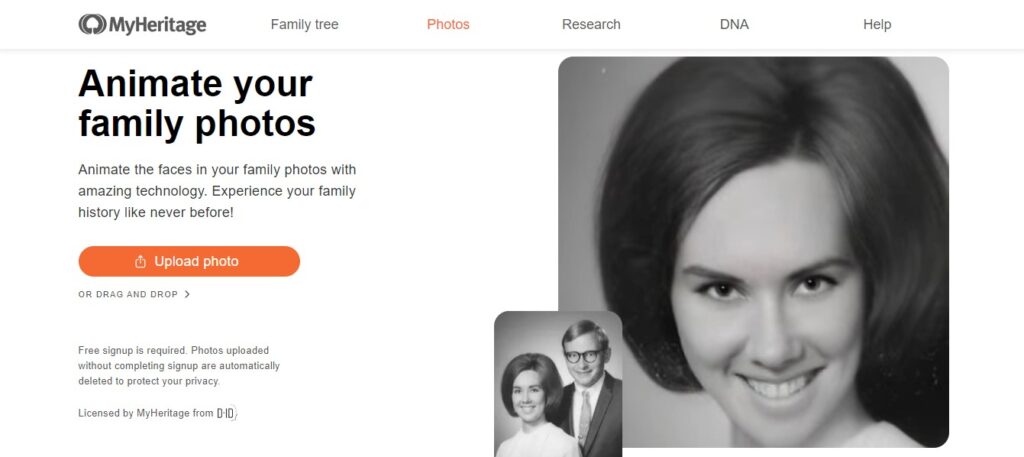

Deep Nostalgia

「Deep Nostalgia」は、過去の人物を生き返らせたかのように動かせるツールです。

このツールは非常に高精度なのが特徴で、まるで故人がよみがえったかのような映像を作り出せます。

オンライン上で利用できるアプリですが、一人の顔しか認識しない、被写体の首までしか使えないといった制約もあり実用性は今ひとつかもしれません。それでも、無料で高い技術力を楽しめるツールなので、ぜひ試してみてください。

ディープフェイクに関するよくある質問

ディープフェイクに関するよくある質問をまとめました。ディープフェイクについてより詳しく知りたい方は、参考にしてみてください。

ディープフェイクについて理解し、上手に活用しよう

ディープフェイクは、人工知能(AI)技術を使用して、実在する人物の顔や声を非常にリアルに模倣した偽のビデオやオーディオクリップを作成する技術です。良い活用事例がある一方で、ディープフェイク技術は悪用されやすく、それによる実害も発生しています。

実際に、フェイクポルノやなりすまし詐欺といった悪用事例が後を絶ちません。

なお、日本では、ディープフェイクに関する法整備はまだ追いついていません。自分自身や身近な人が被害にあわないためにも、ディープフェイクについてしっかりと理解し、自分で自分の身を守ることが大切です。

ディープフェイクの良い面・悪い面、被害にあわないための方法などを理解して、最先端の技術を上手に活用しましょう。

生成系AIの業務活用なら!

・生成系AIを活用したPoC開発

・生成系AIのコンサルティング

・システム間API連携

最後に

いかがでしたでしょうか?

「ディープフェイク」に関する知識は、生成AIの活用を検討する際に避けて通れないテーマです。技術の可能性とリスクを正しく理解し、効果的な戦略を導き出しましょう。

なお、WEELでは企業のセキュリティ対策や生成AI導入に関する相談を随時受け付けています。生成AIのことでお困りの方は、ぜひ気軽にご相談ください。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。 ︎株式会社WEELのサービスを詳しく見る。

︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。 ︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。

- ※1:「杭州新聞聯播」でAIアナウンサーが放送 本物アナは故郷で年越し

- ※2:New Anthony Bourdain documentary deepfakes his voice

- ※3:「AI美空ひばり」に賛否 故人の「再現」議論の契機に

- ※4:【Under Armour】Virtusize導入後、導入前の同期間と比較してVirtusize利用グループのサイズ起因返品率が27%減少

- ※5:アパレルEC購入率2.5倍も 急成長バーチャル試着サービス

- ※6:投降呼びかけるゼレンスキー氏の偽動画 米メタが削除

- ※7:ディープフェイクとは?実例や悪用問題・作り方・アプリを徹底解説

- ※8:まるで本人が…相次ぐ「AIフェイク」あなたは見抜けますか?

- ※9:もし、あなたの卒業アルバムが裸にされたら

- ※10:CEOになりすましたディープフェイクの音声で約2600万円の詐欺被害か

- ※11:iOSとAndroidから顔認証データ盗むマルウェア「GoldPickaxe」、口座に不正アクセス

- ※12:令和5年における特殊詐欺の認知・検挙状況等について(確定値版)

- ※13:IT関連の採用面接でディープフェイク使用が増加…FBIが警告

- ※14:会計担当が38億円を詐欺グループに送金、ビデオ会議のCFOは偽物 香港

- ※15:なぜなくならない?SNS有名人なりすまし広告 クリックすると…

- ※16:ディープフェイクの光と闇──巧妙化で求められる対応とは?

- ※17:SYNTHETIQ VISION: Synthetic video detector(フェイク顔映像を自動判定するプログラム)

- ※18:ディープフェイクはファッション広告をどう変えるのか

- ※19:韓国警察、テレグラム運営法人への調査に着手 ディープフェイク被害

- ※20:性的ディープフェイク 削除要請等の対策強化 こども家庭庁など

- ※21:電話を使ったボイスフィッシング被害が拡大、生成AI活用など攻撃手法は多様化へ

【監修者】田村 洋樹

株式会社WEELの執行役員として、AI導入支援や生成AIを活用した業務改革を中心に、アドバイザリー・プロジェクトマネジメント・講演活動など多面的な立場で企業を支援している。

これまでに累計25社以上のAIアドバイザリーを担当し、企業向けセミナーや大学講義を通じて、のべ10,000人を超える受講者に対して実践的な知見を提供。上場企業や国立大学などでの登壇実績も多く、日本HP主催「HP Future Ready AI Conference 2024」や、インテル主催「Intel Connection Japan 2024」など、業界を代表するカンファレンスにも登壇している。

– Our generated anchors deliver stories that are informative, heartfelt and entertaining.

– Our generated anchors deliver stories that are informative, heartfelt and entertaining.