- ローカル環境でLLMを安全に利用できるデスクトップアプリLM Studio

- OpenAI互換API・RAG機能・SDK対応で開発者支援が充実

- 無料から始められ業務利用も可能、機密性重視のユースケースに最適

LM StudioはElement Labsが提供しているローカル環境で大規模言語モデルを利用できるサービスです。ChatGPTをはじめとするLLMはWebサービスが中心ですが、個人情報やあまり外部に出したくない内容についてやり取りするのが憚られていました。

しかし、LM Studioを使えばローカル環境でLLMを利用できるので個人情報などを守りながらLLMを使うことができます。

本記事ではLM Studioの概要からセッティング方法、実際の使い方について解説をします。最後までお読みいただければ、ご自分のパソコンでLLMを利用できるようになります。

ぜひ最後までお読みください!

\生成AIを活用して業務プロセスを自動化/

LM Studioの概要

LM StudioはElement Labsが提供しているローカル環境でLLMを利用できるサービスです。

GUIベースでChatGPTのようなインターフェースなのでプログラミングの知見がなくとも利用可能です。対象OSはWindows、Mac、Linux。LM Studioを使うことで、モデルのダウンロードから実行、対話、API提供まで全てをローカル環境で完結させられます。

LM Studioは外部サーバーに依存せず、ダウンロードしたオープンソース/オープンウェイトのLLMをPC上で動かせるため、セキュリティを重視する企業や研究用途でも注目されています。

主な機能としては、チャットをはじめ、PDFやDocs、CSVなどをアップロードしてRAGとしても使うことができます。RAGとして使用する場合、アップロードできるファイル数は最大5つ、合計30MBまで対応。

また、APIサーバー機能もあり、LM Studioが立てるAPIはOpenAIのエンドポイントと互換性があり、既存のライブラリやSDKをほぼそのまま利用可能です。REST APIも提供されていて、自作アプリやスクリプトからの呼び出しも可能。

さらにセキュリティとしては、インターネット接続はモデル検索とモデルのダウンロード、アプリのアップデート確認のみに限定されており、ユーザーの入力データやドキュメントは全てローカルに保存され、外部に送信されません。

ローカルLLMについて

ローカルLLMとは、クラウドではなく手元のPCや自社サーバー上でLLMを実行する方式です。ローカルLLMを使用するメリットとしては、次の3つがあります。

- 機密性:入力や添付文書を外部に送らず完結(RAGもローカルで可)。

- 可用性:ネットワーク遅延・外部API障害の影響を受けにくい。

- コスト制御:API従量課金が不要(ただし初期セットアップとハードは必要)。

一方でデメリットもあります。

- 精度・モデル選択の制約:最先端モデルはVRAM/メモリ要件が重い。例として70B級はFP16で約140GB、4bit量子化でも約35GBを要します。

- 運用負荷:モデル配布形式・量子化・ドライバ・依存パッケージなどの管理が必要。

ローカルLLMを使う最大の特徴としては、データがローカル環境内で完結するためデータが外部に送信されず、機密性が高い点です。また、インターネット接続を必要としないためオフライン環境でもLLMを安定して利用できます。

ただし、クラウドでLLMを利用するよりも性能面での制約があったりハードウェア要件が厳しいなどの点も挙げられます。

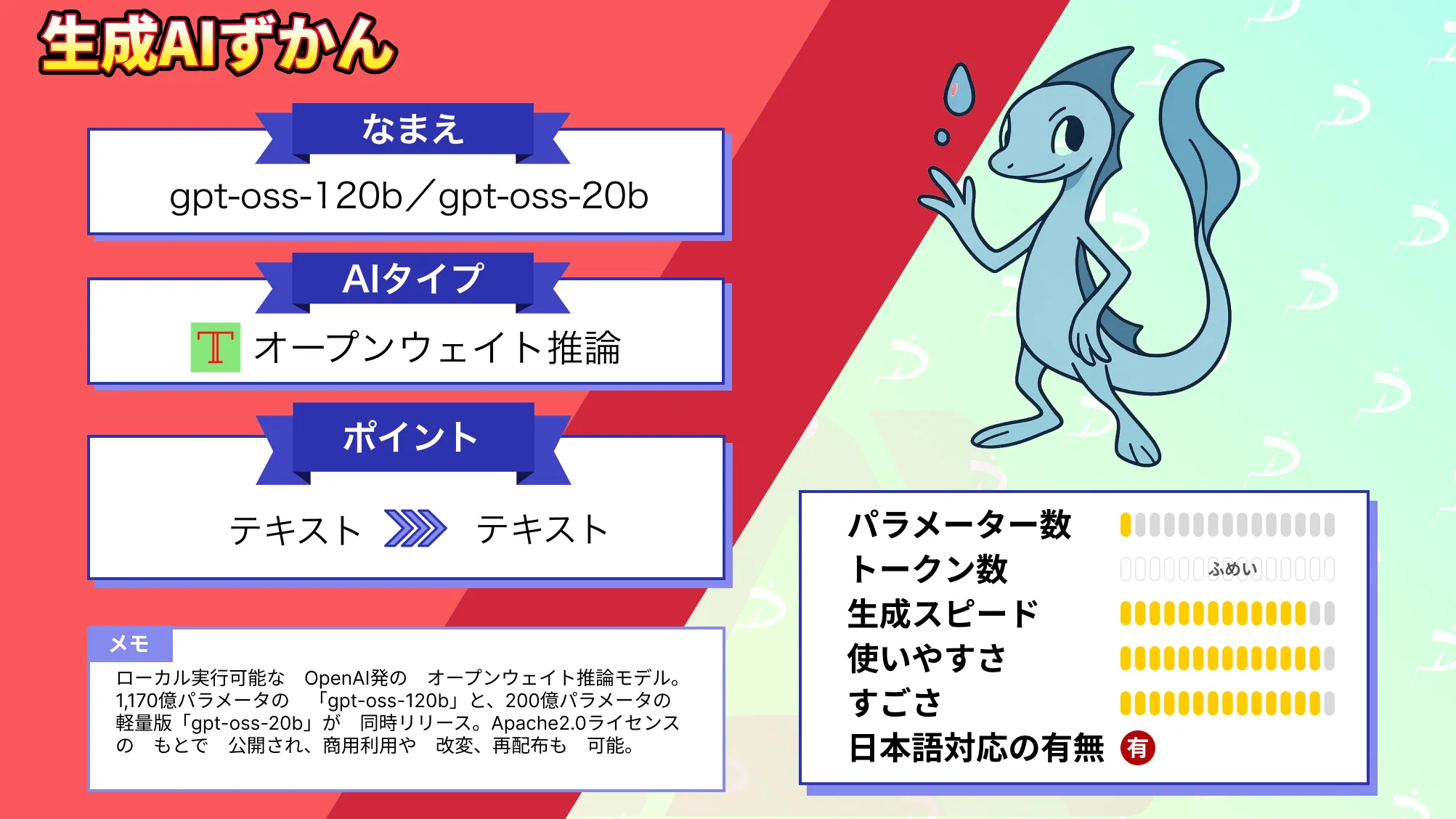

なお、ローカル利用可能なオープンウェイト推論モデルについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

LM Studioの料金

LM Studioは、個人利用から法人利用まで基本的に無料で使えるのが大きな特徴ですが、組織規模や管理機能の要否に応じて複数のプランが用意されています。※1

| Community(無料) | Teams(無料) | Enterprise(有料:要相談) |

|---|---|---|

| ログイン不要、データはすべて端末内で処理LM Studioデスクトップアプリ+更新公開アーティファクトのHub共有商用利用可能 | Communityの全機能Hub組織の作成・チーム招待プライベートアーティファクトのHub共有 | Teamsの全機能カスタムデプロイSSO(Okta・Google Workspace等対応)モデルゲーティング(利用制御)管理者機能・レポーティング優先サポート |

使い分けとしては、以下のようになりそうです。

Community → 個人・業務ともに完全無料

Teams → 無料で始められるが、主にチーム内のプライベート共有を強化

Enterprise → 有料・要問い合わせだが、管理機能やサポートが必要な場合

LM Studioのライセンス

個人利用では商用利用可能と記載されていましたが、それ以外については記載されていませんでした。

しかし2025年7月9日に下記のアナウンスがされています。

元々は業務で利用する場合には別途ライセンスが必要だったようですが、2025年7月9日以降からは業務での利用も無料になっています。※2

LM Studioの使い方

では実際にLM Studioを使っていきたいと思います。

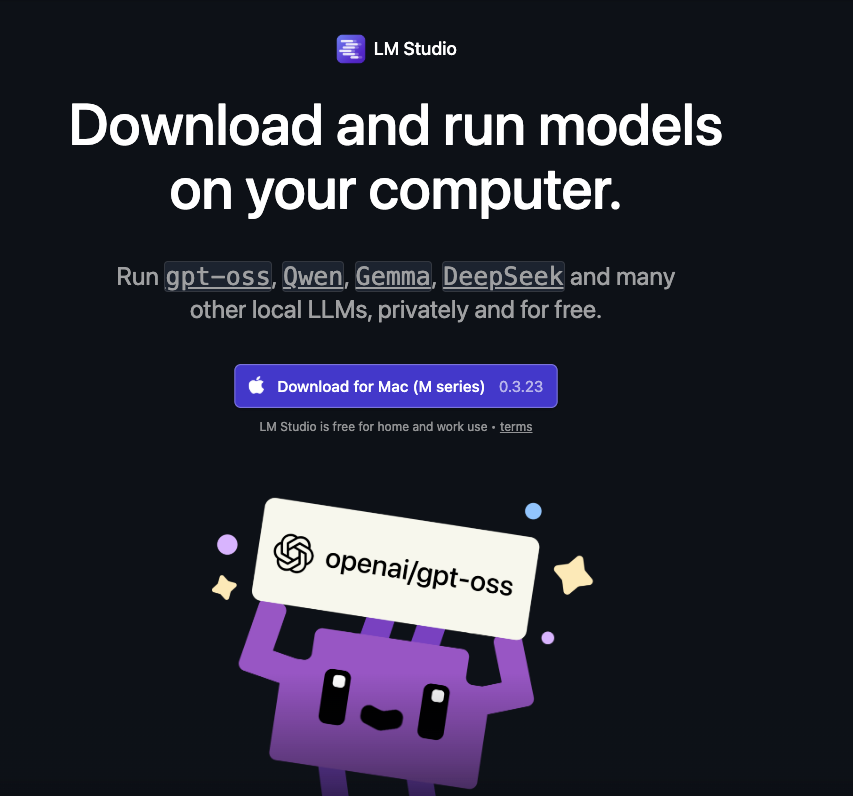

まずはLM Studioをダウンロード・インストールします。

ダウンロードが完了したら、ファイルを展開して、アプリを起動します。

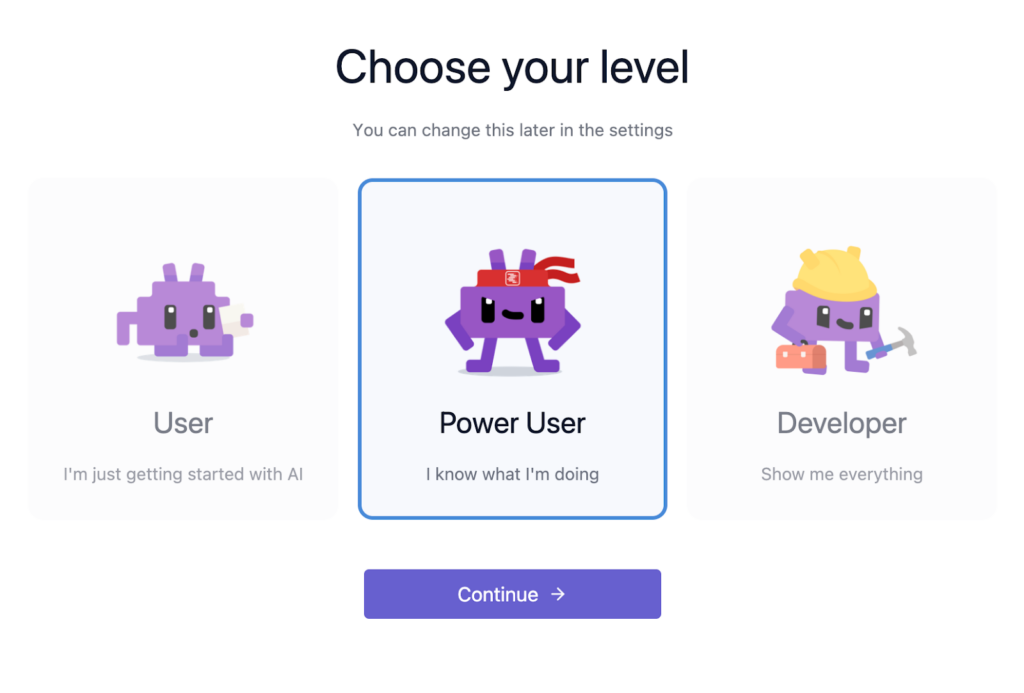

「Get Started」をクリックするとレベルの選択になりますので、どれか一つを選んで「Continue」で次に進みます。

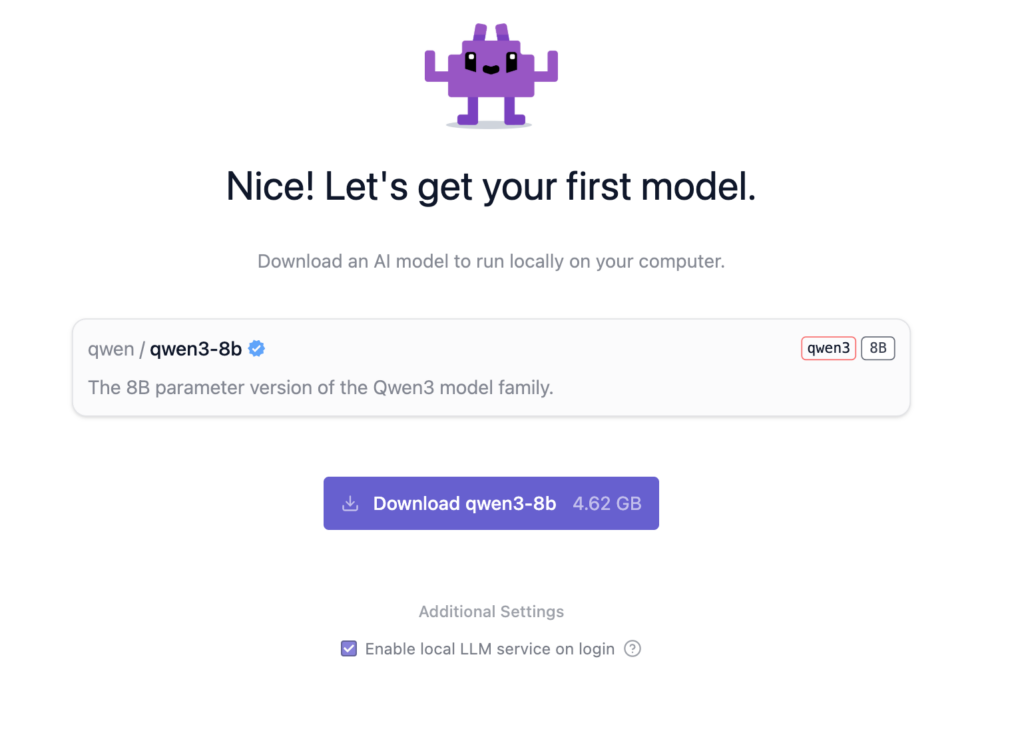

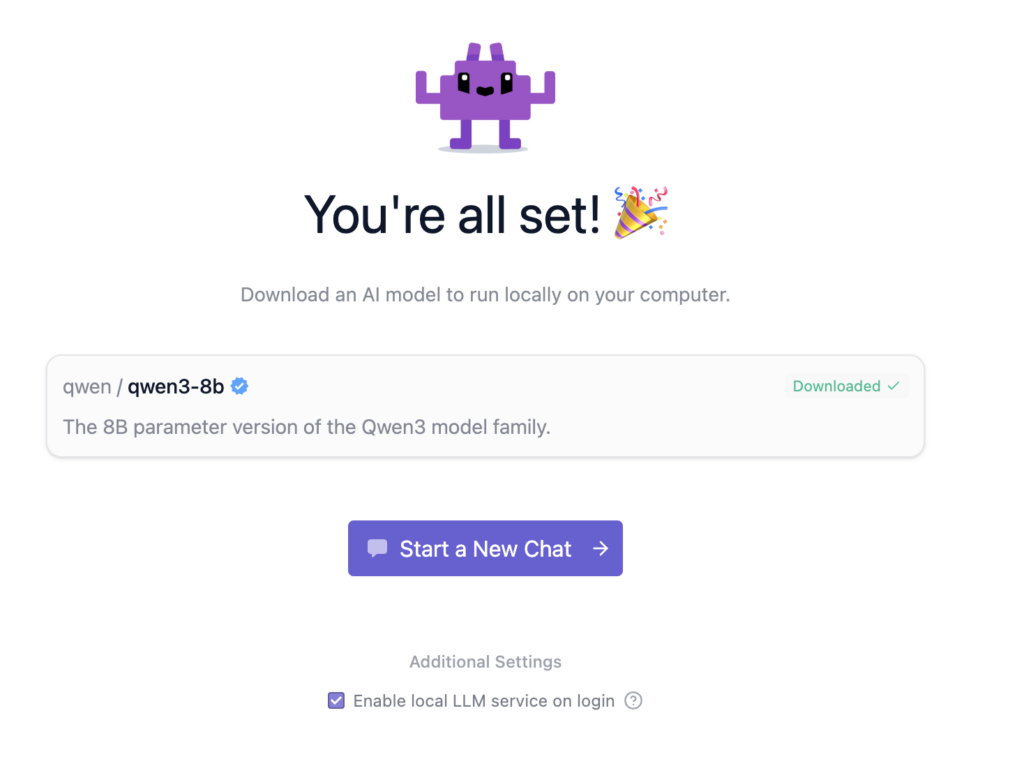

レベル選択が完了すると、モデルダウンロードを促されるのでそのままダウンロードしましょう。

モデルのダウンロードが完了したらチャット画面に進めます。

開発者向けツール

LM Studioは、チャットUIだけでなく、開発者がローカルLLMを自由に組み込めるようにOpenAI互換APIとPython SDK、JavaScript SDK、CLIが用意されています。

公式ドキュメントも用意されているので、そちらを参考にPython SDKを使ってみたいと思います。※3

まずはライブラリのインストール。

pip install lmstudioサンプルコードはこちら。

import lmstudio as lms

model = lms.llm("mistral-7b-instruct-v0.3") #使用するモデル名を入力

result = model.respond("人生の意味とは何ですか?")

print(result)結果はこちら。

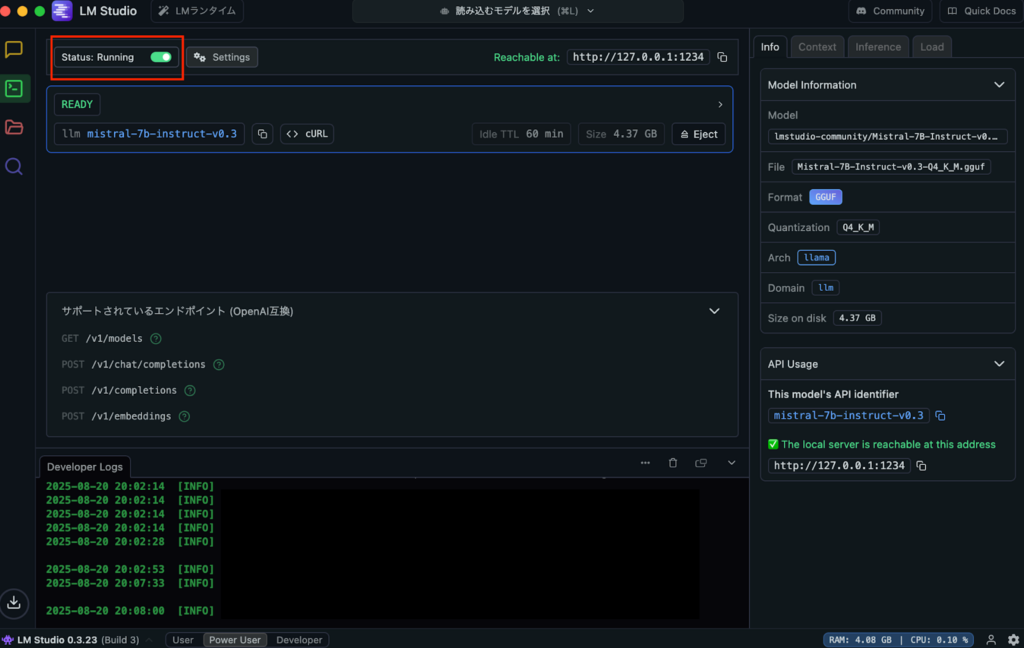

人生の意味は、個人によって異なります。一般的に言えるのは、それは自分自身や他人に向けた学び、成長、愛、努力、貢献にあります。でも、人生の意味は私たちが自らを通じて探求し、見つけるものなので、答えはいつも変化し続けます。また、文化や宗教等では、人生の意味とその目標に関して異なる観点も存在します。SDKを使う場合、LM Studioの開発ボタンをクリックしてStatusボタンをクリックして、起動させる必要があります。

LM Studioを動かすのに必要な動作環境

下記がそれぞれのOSのLM Studioを動かすのに必要な動作環境です。※4

macOS

- 対応チップ: Apple Silicon(M1 / M2 / M3 / M4)

- OS要件: macOS 13.4 以降

- MLXモデルを利用する場合 → macOS 14.0 以降必須

- RAM: 16GB以上推奨

- 8GB Macでも軽量モデル+短めのコンテキストなら動作可能

- 備考: Intel Macは非対応

Windows

- 対応アーキテクチャ: x64 / ARM(Snapdragon X Elite含む)

- CPU要件: AVX2命令セット対応が必須(x64の場合)

- RAM: 16GB以上推奨(モデルによりさらに多く必要)

- GPU: 専用VRAM 4GB以上推奨

Linux

- 配布形式: AppImage

- OS要件: Ubuntu 20.04 以降

- Ubuntu 22より新しいバージョンはテスト不十分

- アーキテクチャ: x64 のみ(aarch64は未対応)

- CPU要件: AVX2サポートが必須

LM Studioの活用事例

X上を見ていると、まだLM Studioを活用した事例というものはなく、実際にLM Studioで〇〇モデルを使ってみた!みたいな報告が多いです。

そこでいくつかLM Studioの活用事例を考えてみたので参考にしてください。

まずはPoCやアプリ開発。新しいサービスにAIを組み込みたいが、クラウドAPIはコストが高く柔軟性に欠ける、といった悩みは多くの方が抱くのではないでしょうか?

LM StudioのOpenAI互換APIを使うことで、既存アプリと簡単に連携可能で APIコストゼロで検証できます。うまくいった場合には、本番はクラウドAPIに移行も容易。

また、研究者・開発者のオフライン作業環境として活用するのも良いでしょう。

特に医療や研究分野では、データの秘匿性が特に重要であり、論文PDFや実験データをローカル環境にアップロードして、LLMに要約や考察生成を依頼することができます。ネット接続不要で、外部流出を気にせず解析可能です。

LM Studioを使ってみた!

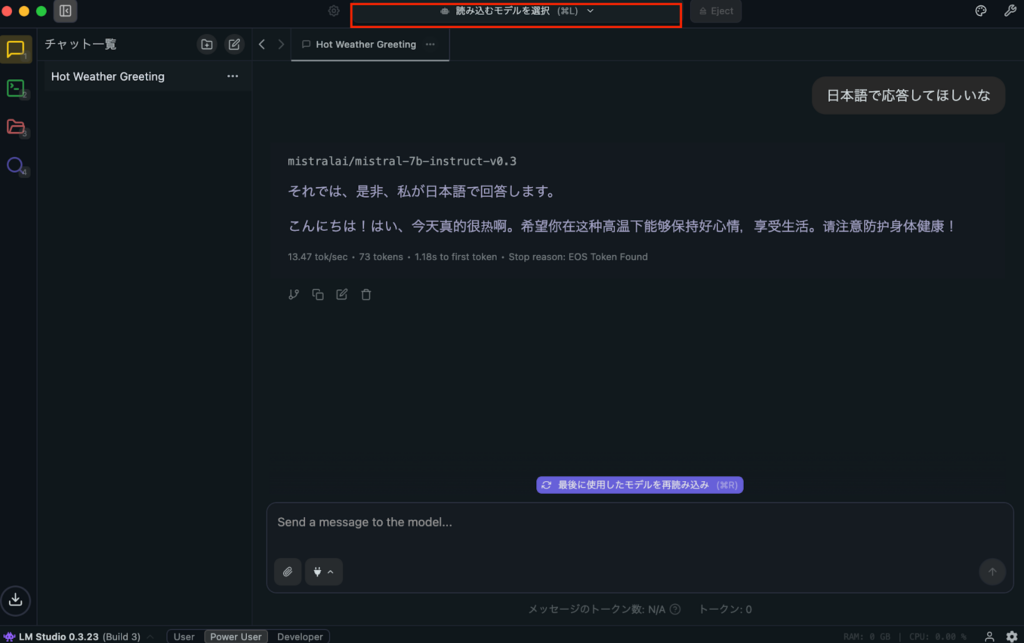

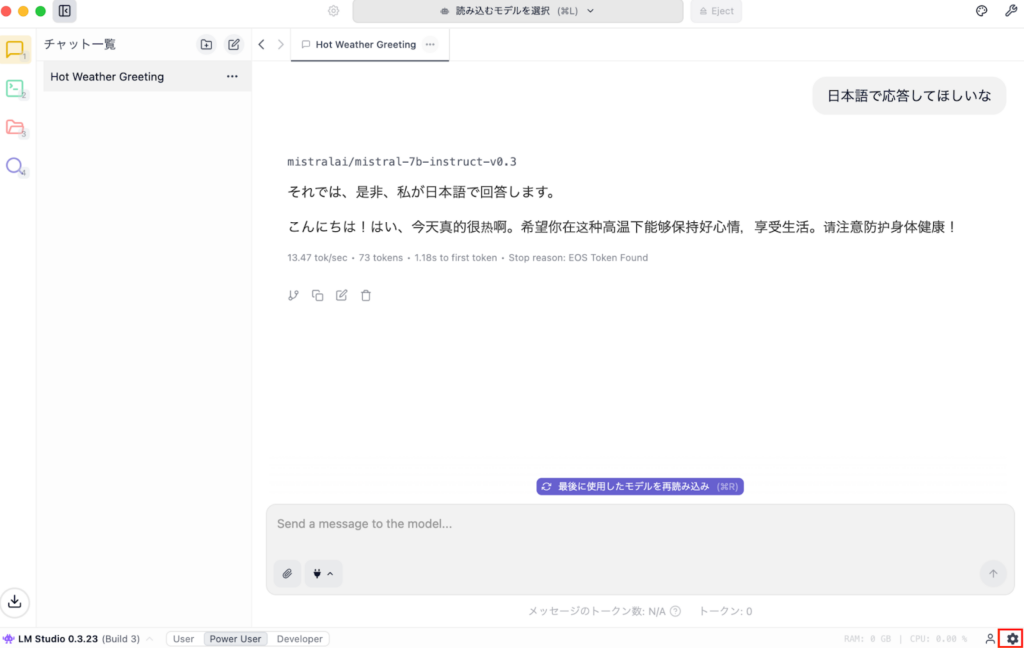

実際にLM Studioを使っている様子がこちらです。

筆者が使っているのは8GBのM2 Mac Book Proです。メモリは7.5GBまで使用しており、動作全般が重たくなりました。

Macの方で8GBの端末でも実行は可能ですが、やはりメモリ容量は多いに越したことはないですね。

System RequirementsにはmacOSは13.4以降であれば使用可能と記載がありましたが、私が実行した時にモデルロードでエラーが発生したので、LM Studioを使う場合には macOSを14以降にしたほうが良いかもしれません。

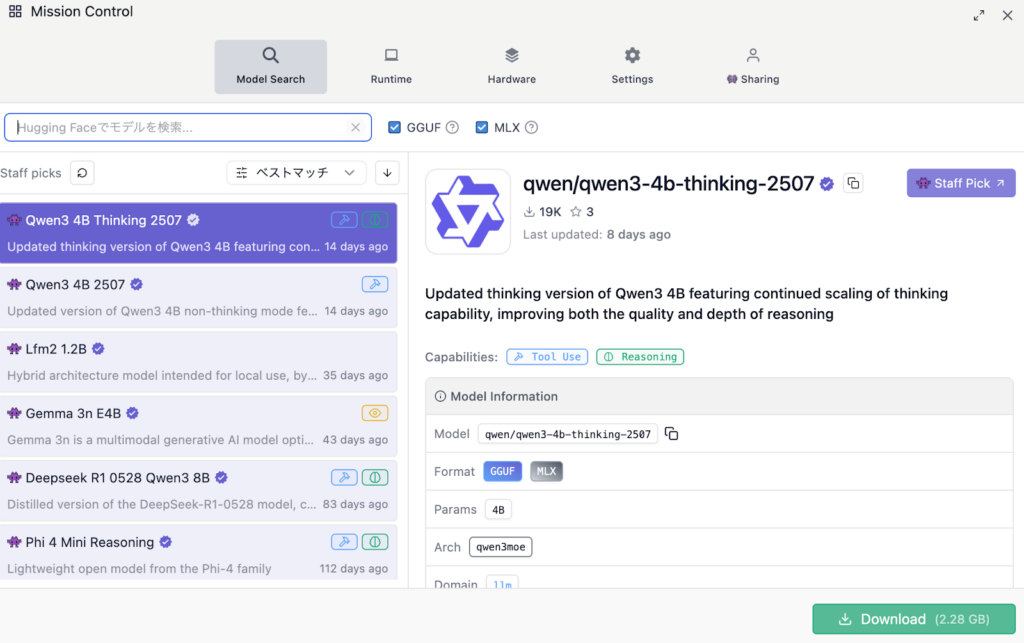

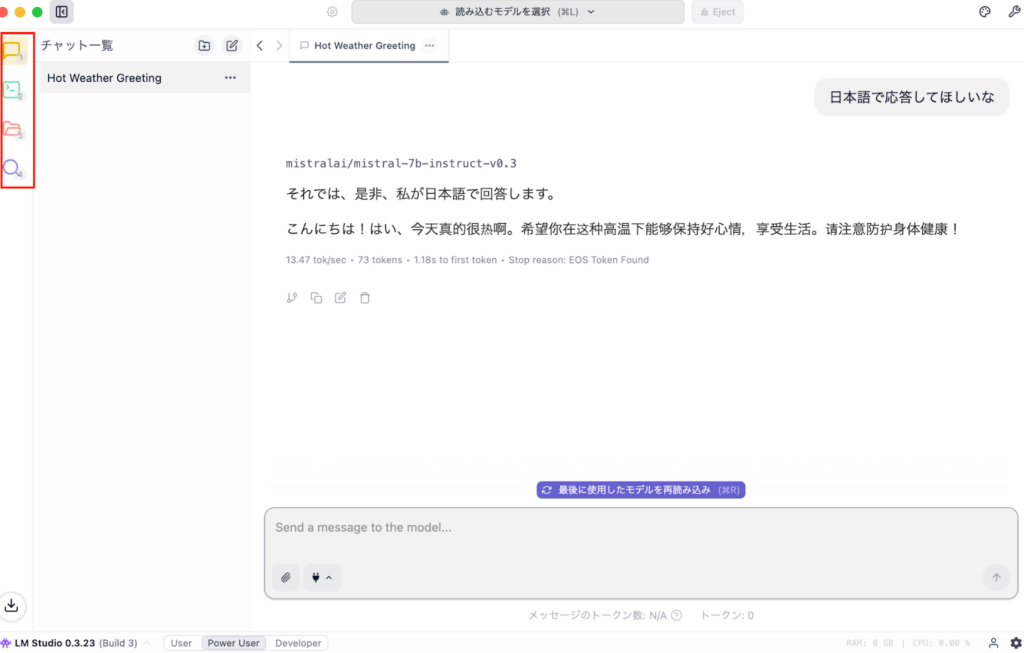

セットアップ完了後に別モデルをダウンロードする場合には、Mission Controlを開けばモデルを選択することができます。

モデルを複数ダウンロードしている場合には、下記赤枠からモデルを選択。

Mission Controlを開くには画面右下の歯車をクリックすれば開くことができます。

またチャット画面の左側には4種類のアイコンが並んでいます。

上からチャット、開発者、マイモデル、検索になっています。Mission Controlは一番下の検索をクリックすることでも開くことが可能。

なお、ローカル環境でLLM推論が可能なOllamaについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

LM Studioを活用してみよう!

LM Studioはローカル環境で大規模言語モデルを安全に動かせるデスクトップアプリケーション。

ChatGPTなどのクラウド型と異なり、データが外部に送信されることなく処理できるため、社内文書や研究データなど機密性の高い情報も安心して扱えます。

研究や教育、業務のPoC、現場でのオフライン利用など幅広いシーンで活用でき、まずは無料のCommunityプランから誰でも気軽に試せるのが大きな特徴なので、ぜひ本記事を参考にLM Studioを使ってみてください!

最後に

いかがだったでしょうか?

ローカルLLMの導入や活用法にお悩みの方へ。業務や研究への応用に関する無料相談を承っています。お気軽にご相談ください。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。 ︎株式会社WEELのサービスを詳しく見る。

︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。 ︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。