- より正確でコンテキストを意識した画像生成が可能

- img2img、インペインティングなど様々な生成モードを利用できる

- 最大1536×1024までの高解像度出力が可能

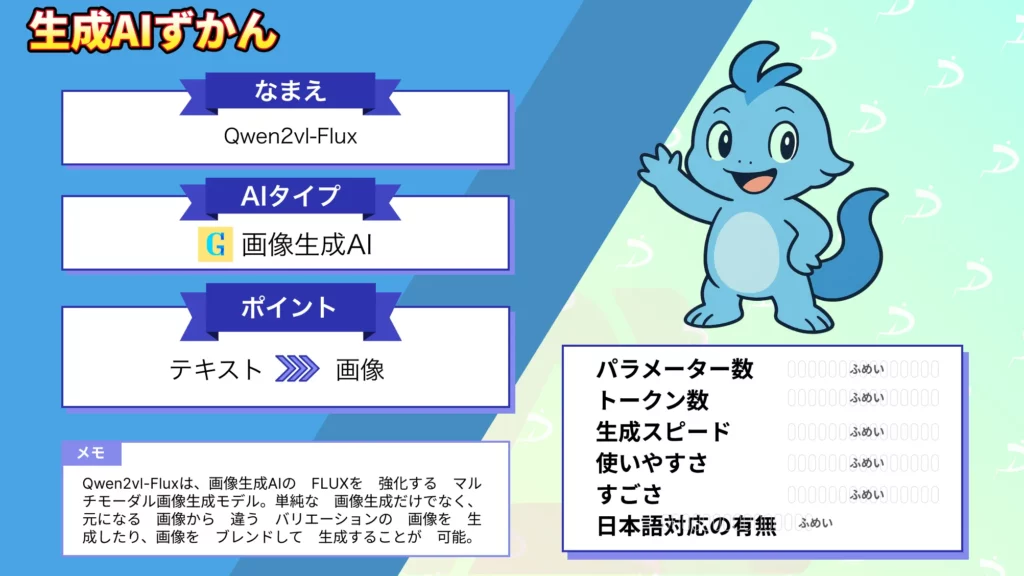

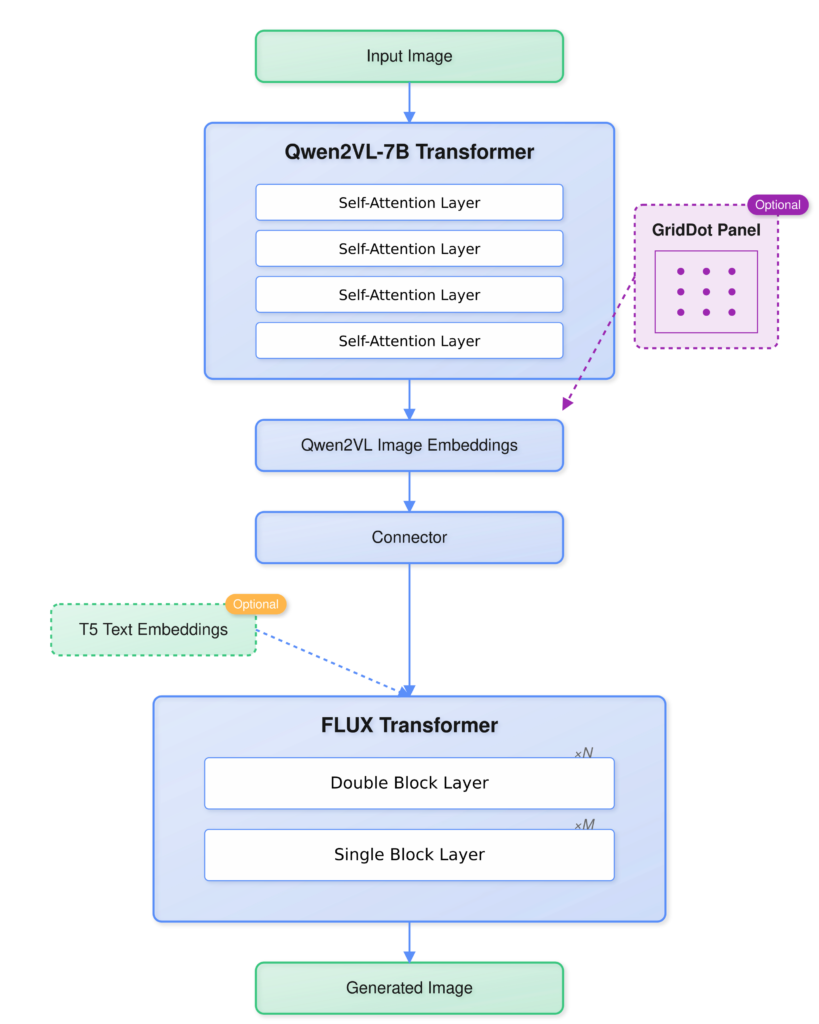

Qwen2vl-Fluxは優れた視覚理解能力を持つQwen2VLを利用しFluxを強化した画像生成モデルです。

複雑な画像への処理や変換、修復などを可能にしています。テキストから画像への変換、画像から画像への変換を正確に行えるのも強みです。さらに目的に応じて複数の生成モードを使うこともできます。

今回の記事では、Qwen2vl-Fluxの使い方と使用例を解説します。

\生成AIを活用して業務プロセスを自動化/

Qwen2vl-Fluxの概要

Qwen2vl-Fluxは、テキスト入力と視覚情報の両方に基づいて高品質な画像を生成できるマルチモーダルなモデルです。

Qwen2vl-Fluxの最大の特徴は、視覚言語理解モジュールにアリババクラウドが発表した視覚言語モデルのQwen2VLを活用している点となります。

参考:https://huggingface.co/Djrango/Qwen2vl-Flux

この言語モデルは、長時間の動画や手書きテキスト、複数のオブジェクトが描かれた画像の内容を正確に理解できるという特徴があります。これにより複雑な画像でも正確に内容を把握できるようになっています。

元の画像の本質を保ったまま多様なバリエーションで生成したり、複数の画像をブレンドしたりと、画像生成のモードが豊富なのもポイントの一つ。また、テキストプロンプトを入力することで画像生成に条件を付けることも可能です。

Qwen2vl-Fluxの基本的な生成モードの例は以下の通りです。

Image Variation

インプットした画像の本質を維持して画像を作り替える機能。テキストプロンプトによりバリエーションの幅を広げられます。

Image Variationのコード例

python main.py --mode img2img \

--input_image source.jpg \

--reference_image target.jpg \

--prompt "xxxxxxxxxxxx" \

--denoise_strength 0.75img2img

インプットした画像に基づいて画像を変換する機能。画像から画像への変換が可能です。

img2imgのコード例

python main.py --mode img2img \

--input_image source.jpg \

--reference_image target.jpg \

--prompt "xxxxxxxxxxxx" \

--denoise_strength 0.75inpaint

マスクを使って画像を修復する機能。

inpaintのコード例

python main.py --mode inpaint \

--input_image image.jpg \

--mask_image mask.png \

--prompt "Fill with beautiful flowers"controlnet

構造ガイダンスに基づいて正確に画像を生成する機能。

以下のオプションがあります

- depth-anything-v2

- mistoline

- segment-anything-v2

controlnetのコード例

python main.py --mode controlnet \

--input_image image.jpg \

--line_mode \

--depth_mode \

--line_strength 0.4 \

--depth_strength 0.2 \

--prompt "xxxxxxxxxxxxxxxxxxxxx"controlnet-inpaint

controlnetガイダンスとinpaintingを組み合わせる機能。

controlnet-inpaintのコード例

# ライン検出なしで深度モデルのみをロードします

python main.py --mode controlnet \

--input_image image.jpg \

--depth_mode \

--depth_strength 0.3 \

--prompt "xxxxxxxxxxxxxxxxxxxxxxxx"

# 深度モデルなしでライン検出のみをロードします

python main.py --mode controlnet \

--input_image image.jpg \

--line_mode \

--line_strength 0.4 \

--prompt "xxxxxxxxxxxxxxxxxxxxxxxxxxx"Qwen2vl-Fluxのライセンス

| 利用用途 | 可否 |

|---|---|

| 商用利用 |  |

| 改変 |  (コピー表記など条件あり) (コピー表記など条件あり) |

| 配布 |  (コピー表記など条件あり) (コピー表記など条件あり) |

| 特許使用 | 不明(記載なし) |

| 私的使用 |  |

Qwen2vl-Fluxのライセンスは下記2つのライセンスを継承しています。

- Qwen2-VL (Apache 2.0)

- FLUX.1 [dev] (Non-Commercial License)

Qwen2-VLはApache 2.0のライセンスなので、商用利用も無料です。

一方、FLUX.1 [dev]は(Non-Commercial Licenseと表記されているため商用利用は不可となっています。

そのため、Qwen2vl-Fluxを商用利用する場合にはFLUXチームに問い合わせる必要があります。

Qwen2vl-Fluxのライセンスについて、詳しくは下記ページをご確認ください。

\画像生成AIを商用利用する際はライセンスを確認しましょう/

Qwen2vl-Fluxの使い方

ここからは、Huggingfaceを参考にQwen2vl-Fluxを実際に使う方法を解説します。

Qwen2vl-Fluxの実装方法

Qwen2vl-Fluxの動作環境は下記のとおりです。

Python version : 3.12.4

pip version : 24.3.1

PyTorch 2.4.1 以上

メモリ要件: 48GB以上のVRAMまずはGitHubのリポジトリをクローンして、各種ライブラリをインストールします。

git clone https://github.com/erwold/qwen2vl-flux

cd qwen2vl-flux次に、仮想環境を作成します。

python -m venv venv

source venv/bin/activate # Linux/Mac

# or

venv\Scripts\activate # Windowsそして、依存関係をインストールします。

pip install -r requirements.txt必要なパッケージ

- PyTorch >= 2.4.1

- Transformers 4.45.0

- Diffusers 0.30.0

- Accelerate 0.33.0

最後にモデル チェックポイントをダウンロードします。HuggingFace からQwen2VL-Fluxモデルファイルをダウンロードし、指定のディレクトリに配置します。

from huggingface_hub import snapshot_download

snapshot_download("Djrango/Qwen2vl-Flux")モデルファイルの格納先ディレクトリ

【ディレクトリ構造】

checkpoints/

├── flux/ # Main Flux model files

├── qwen2-vl/ # Qwen2VL model files

最後に

いかがだったでしょうか?

テキストがデザインを描き出す時代。生成AIを貴社の新しい事業価値のエンジンに変える第一歩として踏み出しませんか。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。 ︎株式会社WEELのサービスを詳しく見る。

︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。 ︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、弊社紹介資料もご用意しておりますので、併せてご確認ください。